作者|芯芯

英伟达正站在一个矛盾而关键的历史节点:市值屡创新高,股价牵动全球市场;同时又以单季度数百亿美元营收、近70%毛利率,成为AI浪潮中最坚实的基石。

在2026年CES上,CEO黄仁勋开场即指出:「我们有15公斤内容要塞进这场演讲」——现场3000人、庭院2000人、四楼另挤进1000人,全球数百万观众在线观看。但真正重要的不是规模,而是他随后提出的判断:

「计算机行业正经历两次平台迁移同步发生。」

01 智能体:用户的新「界面」

第一次迁移是AI原生化——应用必须构建于AI之上;第二次则更深层:软件开发范式、运行方式乃至整个技术栈正在被重写。

黄仁勋指出,全球数万亿美元规模的传统产业,正将研发预算中的“几个百分点”系统性转向AI。这不是增量投入,而是旧方法向AI方法的整体迁移,解释了当下行业的普遍高负荷状态。

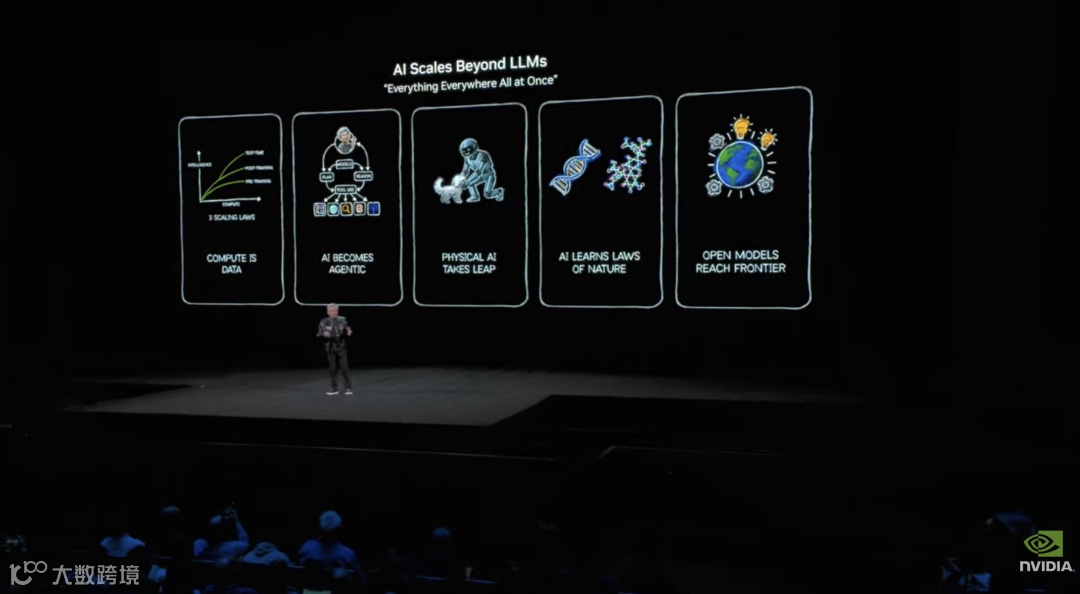

他梳理了AI发展的关键节点:2015年BERT让语言模型初具实用价值;2017年Transformer奠定架构基础;2022年ChatGPT实现大众认知突破;真正的拐点出现在2023年o1推理模型问世,使AI具备「思考过程」;2024年起Agentic AI(智能体)快速涌现,并于2025年全面扩散。

这类系统可查资料、调用工具、规划步骤、模拟未来、拆解问题,甚至完成未经明确训练的任务。其能力正通过开源模型向全球加速释放。

图片来源:英伟达

令黄仁勋尤为兴奋的,不是闭源大模型的进步,而是开源模型的集体跃迁。目前主流开源模型距前沿水平仅“落后六个月”,且每半年即迭代升级,驱动全球开发者、创业公司、科研机构与高校广泛参与。

他强调,英伟达已从GPU供应商,转型为前沿开源模型构建者——且坚持完全开放。

图片来源:英伟达

他在CES一口气公布了多项开源成果:混合架构的Nemotron语言模型、世界基础模型Cosmos、人形机器人Groot,以及自动驾驶AI Alpamayo——后者不仅开源模型,还开源训练数据。

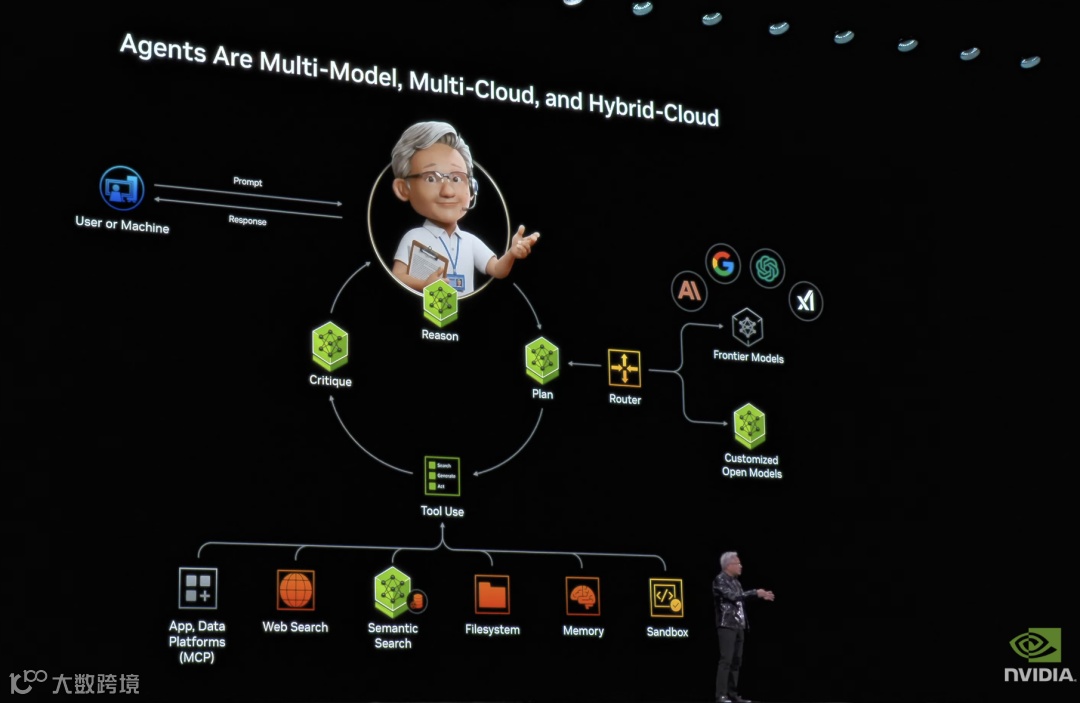

黄仁勋提出,未来AI将不仅是多模态,更是「多模型」:最聪明的系统应按任务动态调用最合适模型;最真实的系统必然是多云、混合云与边缘协同的架构。

图片来源:英伟达

这意味着AI应用的本质,是一套调度与推理架构:识别用户意图、选择最优模型、调用外部工具、组合输出结果——即「智能体」。

黄仁勋明确表示:这种智能体正在成为新的用户界面,取代Excel、表单和命令行。

02 物理AI:从虚拟走向现实

如果说Agentic AI重构了软件世界,物理AI(Physical AI)则正在重塑现实。

黄仁勋指出,让AI理解物理常识远比掌握语言更难:物体恒存、因果律、惯性、摩擦、重力……这些对人类幼儿是直觉,对AI却是全新挑战。而真实世界的高质量交互数据永远稀缺。

图片来源:英伟达

构建物理AI需「三台计算机」:用于大规模训练的集群、部署在车/机器人/工厂边缘的推理单元,以及支撑仿真的数字孪生平台。Omniverse负责仿真,Cosmos作为世界基础模型,Groot与Alpamayo则分别对应机器人与自动驾驶场景。

训练数据从何而来?语言模型有海量文本,但物理世界的真实视频不足以覆盖复杂交互。解决方案是:用符合物理定律的合成数据生成技术,有针对性地制造高质量样本。

例如,交通模拟器输出有限,就将其输入Cosmos,生成物理可信的环视视频用于训练;Cosmos还能从单图生成视频、从3D描述生成连贯运动、从传感器日志生成环视视频,并针对「边缘案例」主动构造训练素材,实现闭环仿真。

黄仁勋称:「Physical AI的ChatGPT时刻即将到来。」

他正式发布Alpamayo——「世界首个会思考、会推理的自动驾驶AI」。该系统端到端连接摄像头与执行器,融合真实驾驶里程、Cosmos生成里程,及数十万精细标注样本。

图片来源:英伟达

其突破在于:不只输出方向盘角度与油门刹车指令,更实时说明「将采取什么动作」「为何如此决策」「预测轨迹如何」。面对长尾场景,系统不再依赖穷举采集,而是通过推理拆解为子情境并组合应对。

黄仁勋解释,八年前启动自动驾驶项目,正是因为预判深度学习将彻底重构计算栈。他将AI体系比作「五层蛋糕」:底层是能源与设备(如车辆本体);第二层是芯片与网络;第三层是基础设施(Omniverse、Cosmos);第四层是模型(Alpamayo);顶层是应用(如奔驰)。

Alpamayo「今日开源」,工程团队规模达数千人。奔驰已于五年前启动合作。黄仁勋预测:未来将有十亿辆自动驾驶汽车,每一辆都将具备思考能力。首批车辆将于Q1上路,Q2进入欧洲,Q3-Q4逐步扩展至亚洲,版本将持续更新。

他定义自动驾驶为Physical AI的首个「大规模主流市场」,断言「拐点就在当下」,并指出「三台计算机+合成数据+仿真」的方法论将快速迁移至机械臂、移动机器人与全尺寸人形机器人领域。

图片来源:英伟达

03 Vera Rubin:新一代计算平台发布

在阐述完产业方向后,黄仁勋回归硬件,正式发布新一代计算平台Vera Rubin。

图片来源:英伟达

平台命名致敬天文学家Vera Rubin——她发现星系旋转异常,从而推断出暗物质存在。英伟达以此隐喻:当前膨胀的,是「看不见却无处不在」的算力需求。

模型规模年增10倍,o1类推理引入「思考过程」,强化学习后训练加剧,test-time scaling令单次推理token量再增5倍;同时每代前沿token成本以年均10倍速度下降——印证着空前激烈的竞争格局。

图片来源:英伟达

因此,英伟达必须「每年推进一次计算的state-of-the-art,一年都不能落下」:GB200已量产,GB300全规模交付,Vera Rubin平台「今日全面投产」。

Vera Rubin采用「六芯协同」架构:定制CPU(Vera)性能翻倍;Vera与Rubin GPU双向一致性共享数据,延迟更低;单块计算板集成17000个组件,提供100 PFLOPS AI算力,为上代5倍。

网络层面,ConnectX-9为每GPU提供1.6 Tbps横向带宽;BlueField-4 DPU卸载存储与安全任务;计算托盘实现「无缆线、无水管、无风扇」设计;第六代NVLink交换互联18节点,支持72颗Rubin GPU像单一GPU协同工作;向外延伸至Spectrum-X光子以太网,512通道、200G共封装光学互联,支撑万级机柜级「AI工厂」。

图片来源:英伟达

面对摩尔定律放缓,英伟达打破内部「每代最多换两颗芯片」的约束,全面启用co-design(协同设计):Rubin GPU浮点性能为Blackwell的5倍,晶体管数量仅1.6倍,性能提升主要来自架构与系统级优化。

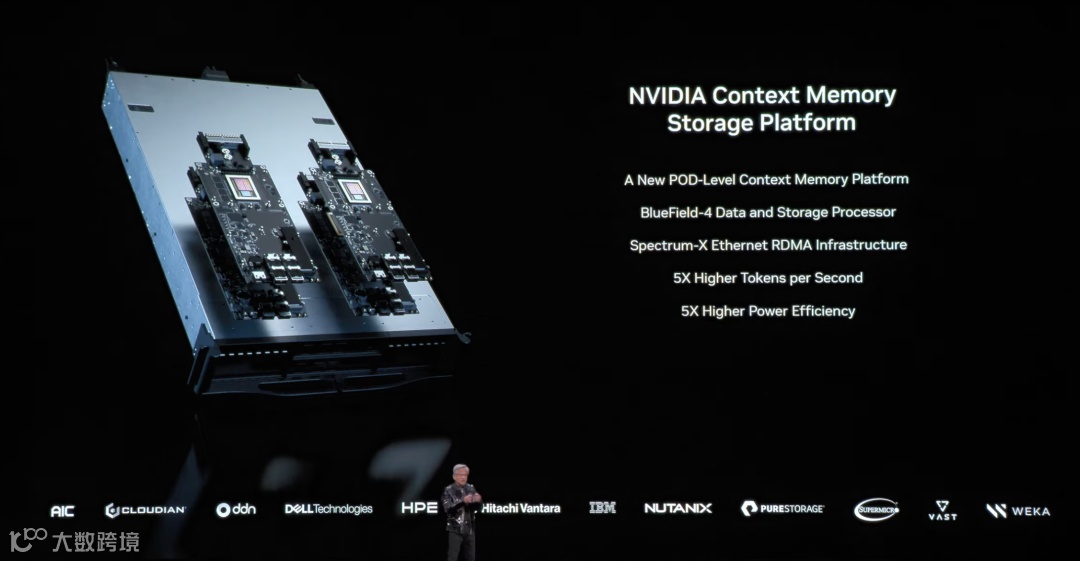

为解决AI上下文记忆瓶颈,英伟达推出机柜内超高速KV cache存储平台:由BlueField DPU统一管理上下文,就近部署于GPU旁。单GPU上下文空间从约1TB扩展至17TB;单BlueField挂载150TB级上下文存储,通过东西向高速织网互联——这已非简单扩容,而是新增一类存储层级。

图片来源:英伟达

新平台具备三大系统级能力: - 水冷效率大幅提升,45℃温水即可冷却,预计节省全球数据中心约6%电力; - 全链路机密计算:传输中、静止时、计算中全程加密,覆盖PCIe、NVLink、CPU-GPU互联; - 电力平滑技术:消除AI负载瞬时尖峰(最高25%),供电预算利用率接近100%。

图片来源:英伟达

在10万亿参数、100万亿token的典型训练任务中,Rubin仅需Blackwell四分之一的系统规模,即可在相同周期内完成训练。

图片来源:英伟达

Rubin相较Hopper、Blackwell的连续跃迁,配合token成本再降一个数量级,正是英伟达「将所有人推向下一前沿」的核心策略。

黄仁勋总结:英伟达已从芯片公司,成长为覆盖芯片、基础设施、模型、应用的「全栈AI公司」;而AI正在重写全球计算栈,其使命就是把整套新栈构建出来,供全球开发者打造应用。

图片来源:英伟达

在消费电子主舞台CES上占据核心位置,标志着英伟达已成为一种「情绪资产」:乐观时被视为AI时代的石油,悲观时被类比为2000年的思科。其市值之巨,已使单日涨跌直接影响市场整体体感。

当一家公司同时掌控技术叙事、产业链关键位、金融市场注意力时,它便升华为行业图腾。图腾带来信仰溢价,也意味着零容错压力。

英伟达能否持续屹立?可能性始终存在。但更值得重视的是其应对策略:加速从「卖芯片」转向「建生态」。当硬件、网络、调度、工具链全部自主可控,领先优势就不再是单代GPU的算力差距,而是系统级复杂度带来的生态摩擦壁垒——对手即便追平算力,也难以跨越整个技术栈的协同门槛。