数据治理的核心组件与工具选型指南

深入解析Apache Atlas在大数据环境中的应用

在上一篇《数据治理:大模型风光背后,那道被忽视的“隐形门槛”》中,我们探讨了数据治理对AI项目成功的关键作用。本文将系统介绍数据治理的六大核心组件、主流工具选型策略,并重点解析开源框架Apache Atlas的技术架构与实践应用,助力企业构建可靠的数据基础体系。

数据治理的核心组件

数据治理如同为企业的数据体系建立“交通规则与监管系统”,确保数据高效、安全、有序流动。其核心由六大组件构成,形成闭环管理体系:

-

数据质量治理

保障数据的准确性、完整性与及时性。例如,金融风控模型要求使用7天内的交易数据,确保评估时效。 -

元数据管理

管理数据的定义、来源与业务语义。例如,追踪AI训练数据是否获得用户授权。 -

数据安全治理

实施数据分级分类与访问控制,必要时进行脱敏或加密。例如,医疗数据需通过RBAC权限审批机制管控访问。 -

数据标准管理

统一命名与编码规范,避免歧义。例如,统一使用“customer_id”而非“cust_id”,国家代码遵循ISO标准。 -

主数据管理

维护客户、产品等核心业务实体的唯一准确记录。适用于企业合并时整合多系统客户信息。 -

数据生命周期管理

制定数据存储、归档与销毁策略。例如,电商平台需保留用户行为数据至少2年以满足合规要求。

主流数据治理工具介绍

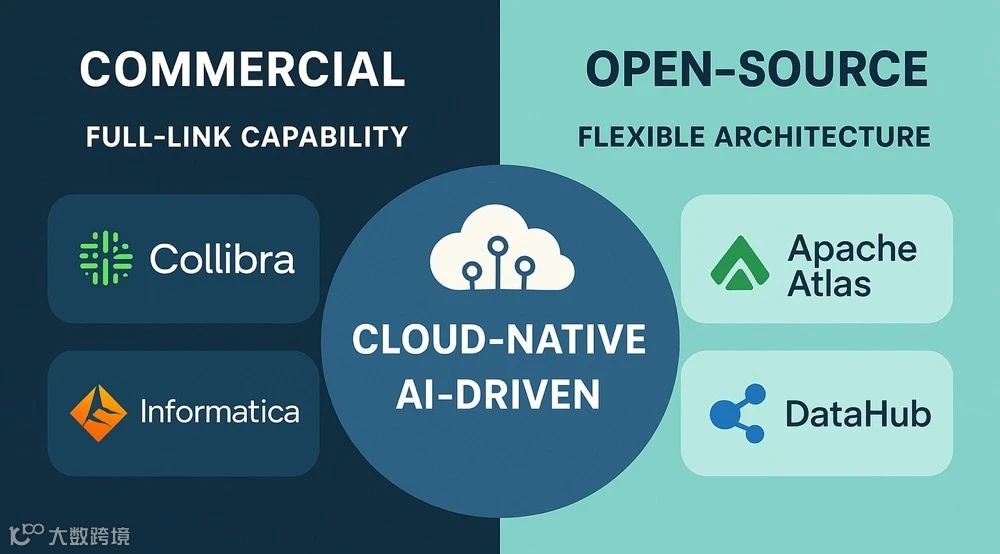

数据治理工具是将治理策略落地执行的“信号灯与智能调度系统”。当前市场主要分为商业解决方案与开源工具两大阵营,满足不同企业需求。

1、商业工具

工具名称 |

核心功能 |

适用场景 |

特点 |

|---|---|---|---|

Informatica Axon |

数据目录、元数据管理、数据血缘、数据质量 |

大型企业复杂数据环境 |

端到端治理,深度集成Informatica生态 |

Collibra |

数据目录、数据字典、业务术语表、合规管理 |

金融/医疗等强合规行业 |

业务友好,支持数据民主化 |

Alation |

数据目录、元数据搜索、AI辅助数据发现 |

技术与业务协作场景 |

AI驱动,支持自然语言查询 |

IBM Watson Knowledge Catalog |

数据目录、AI模型治理、隐私合规 |

混合云/AI项目 |

集成IBM Cloud与AI能力 |

SAP Data Intelligence |

数据集成、元数据管理、数据流水线 |

SAP生态企业 |

深度集成SAP产品线 |

2、开源工具

工具名称 |

核心功能 |

适用场景 |

特点 |

|---|---|---|---|

Apache Atlas |

元数据管理、数据血缘、分类与标签 |

Hadoop生态企业 |

与Hive/HBase深度集成 |

DataHub |

数据目录、元数据搜索、实时血缘分析 |

中大型互联网公司 |

基于Kafka+GraphQL现代架构 |

Amundsen |

数据发现、元数据搜索引擎 |

数据科学家高频查询场景 |

界面简洁,搜索效率高 |

OpenMetadata |

数据目录、数据质量、血缘分析 |

全栈数据治理需求 |

集成Airflow、dbt等工具 |

商业工具与开源工具在多个维度存在差异:

- 功能完整性:商业工具提供“开箱即用”的全功能套件;开源工具需组合使用,灵活性高但集成成本大。

- 使用体验:商业工具界面友好,适合非技术人员;开源工具偏向技术导向,需开发维护能力。

- 成本结构:商业工具年费5–20万美元,含技术支持;开源工具免费,但运维人力成本较高。

- 扩展性:开源可定制源码,自主性强;商业工具依赖厂商更新节奏。

- 合规支持:商业工具内置GDPR等合规模板;开源需自行实现合规逻辑。

- 云部署:商业工具支持SaaS一键部署;开源需自建容器化运维体系。

总体而言,商业工具适合预算充足、合规要求高的企业;开源工具更适合技术能力强、追求自主可控的团队。

开源工具 Apache Atlas 介绍

Apache Atlas 凭借与 Hadoop 生态的深度集成,成为大数据平台中最常用的开源数据治理工具之一。对于已采用 Hive、HBase、Spark 等组件的企业,Atlas 提供了低成本、高集成度的元数据管理与数据血缘追溯方案。

1、核心功能

- 元数据管理:支持从 Hive、HBase、Kafka 等多源采集元数据,通过灵活类型系统定义数据资产属性。

- 存储架构:元数据基于 JanusGraph 存储于 HBase,并通过 Solr 或 Elasticsearch 实现高效索引与检索。

- 数据血缘追踪:支持表级与列级血缘分析,可视化展示数据流转路径,便于问题溯源与影响评估。

- 分类与标签:支持按业务域或敏感度(如PII)打标,辅助合规与权限控制。

- 搜索与发现:提供Web UI与REST API,支持类搜索引擎式的数据查找。

- 安全集成:与 Apache Ranger 深度集成,实现基于标签的访问控制策略。

2、技术架构

- 核心组件

- Type System:定义元数据模型,支持动态扩展。

- Metadata Repository:基于 JanusGraph + HBase 存储,结合 Solr/Elasticsearch 提供索引服务。

- Hook 机制:嵌入 Hive、Spark、Sqoop 等组件,自动捕获元数据与血缘。

- RESTful API:所有功能通过标准接口开放,便于系统集成。

- 集成能力

- 与 Apache Ranger 联动实现安全策略管控。

- 通过 REST API 与 Kafka 消息接口对接 BI 工具、数据仓库等外部系统。

3、部署与运维指南

- 部署模式:生产环境推荐高可用集群部署,避免单点故障。

- 依赖组件:需提前配置 HBase(存储)、Solr/Elasticsearch(索引)、Kafka(异步通知)。

- 运维管理:重点关注元数据同步状态、API健康度与索引一致性;可通过REST API和命令行工具实现自动化运维。

结语

数据治理是企业数字化转型的核心支撑,关乎数据价值释放、合规保障与AI工程化落地。从核心组件到工具选型,企业应结合规模、行业特性与技术栈制定适配策略。

随着AI与云原生技术融合加深,数据治理正向自动化、实时化、智能化演进,为企业的数字未来构建更加坚实的数据底座。