AI 网络系列:

谷歌将在 ISCA 2023

暨计算机体系结构国际研讨会

正式公布最新的 TPU v4 超级计算机

与业界主流

几款同类型芯片相比

谷歌认为其方案更快更节能

而其中的关键之一

就是谷歌部署了OCS

即自研的光交换机 - Apollo

谷歌Apollo:DCN网络游戏规则改变者

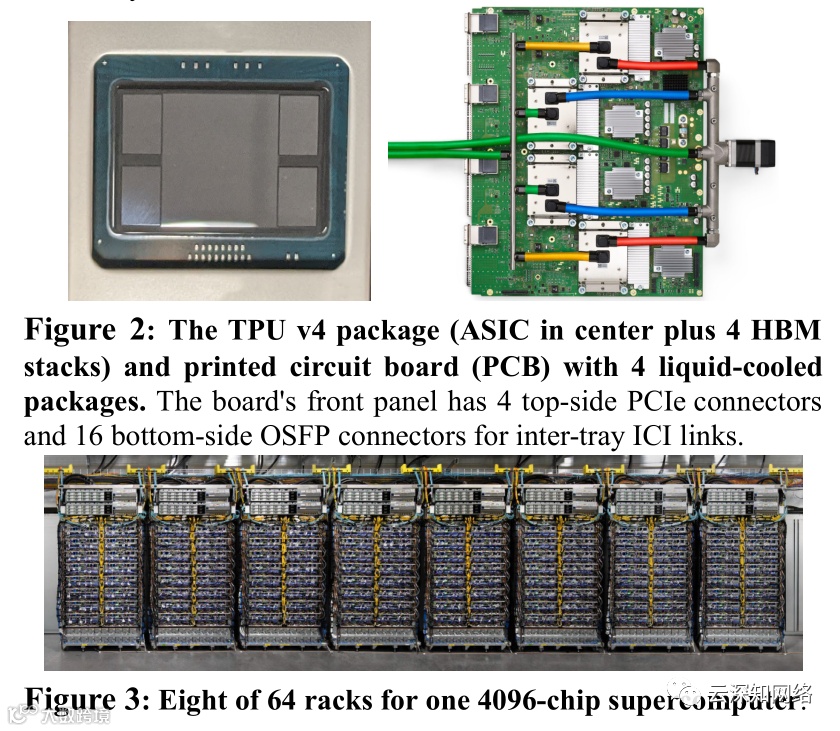

为了应对机器学习(ML)模型的创新,生产工作负载发生了根本性的快速变化。TPU v4是谷歌第五个特定领域架构(DSA),也是其用于此类ML模型的第三台超级计算机。光交换(OCS)动态地重新配置其互连拓扑结构,以提高规模、可用性、利用率、模块化、部署、安全性、功率和性能;用户可以根据需要选择扭曲3D Torus拓扑结构。

与Infiniband相比,OCS和底层光学元件的成本要低得多,功率也低得多,速度也快得多,占系统成本<5%,系统功率<3%。每个TPU v4都包括SparseCores,即数据流处理器,可将依赖嵌入的模型加速5-7倍,但只使用5%的芯片面积和功率。

自2020年部署以来,TPU v4的性能比TPU v3高出2.1倍,性能/瓦特提高2.7倍。TPU v4超级计算机采用4096颗芯片是之前的4倍,因此整体速度快了~10倍,叠加OCS的灵活性一起助力大型语言模型。对于类似规模的系统,它比Graphcore IPU Bow快~4.3倍-4.5倍,比Nvidia A100快1.2倍-1.7倍,耗电少1.3倍-1.9倍。部署在谷歌云的能源优化仓库规模数据中心的TPU v4超级计算机,比on-premise数据中心的同期DSA相比使用的能源少3倍,产生的CO2e少20倍。

关于OCS的详细细节

继续推荐阅读上文中的链接

谷歌在本论文中更强调了OCS的优势

7.2 OCS与NVLink和NVSwitch有何不同?

自2017年以来,每个TPU都内置路由用于在Torus中链接(ICI)相邻芯片。与NVlink一样,它实现了TPU的 "Glueless "连接,但规模更大,支持256个TPU v2和1024个TPU v3。

作为对使用电交换的NVSwitch的回应,我们认为光交换是我们互连的下一代选择。OCS是通过镜面连接的光纤,所以任何带宽的数据都可以在OCS输入和输出光纤之间进行切换。

今天,OCS可以在4096个芯片(将来甚至会更多)输入和输出光纤之间切换。例如,一个OCS可以通过波分复用来处理单链路到若个terabits/second。此外,所有的输入和输出间是全交换,尽管要求连接也必须是1:1。

7.3 如果TPU v4使用IB而不是OCS会怎样?

让我们从Infiniband(IB)与OCS交换机的对比开始。就像NVLink连接DGX中的8个GPU一样,8个TPU将使用ICI。遵循Nvidia的指导,通过一个3级胖树混合链接IB/ICI网络。以每个GPU平均一个网卡计算,一个1120 A100超级平台需要164个Mellanox QM8790 40端口IB交换机,每个交换机的价格在15000-18000美元之间 。额外需要1120张IB网卡。为了取代48个128端口的OCS,4096个TPU v4需要568个IB交换机。OCS每端口的成本并不比IB交换机高,但它可以支持更高的带宽,因为它是被动地反射在源头经过编码的光。因此,混合IB/ICI选项的成本要高得多。

此外,IB交换机的动态数据包处理功耗,与OCS中保持MEMS镜面的配置方向所需的少量功率相比更耗电。

ICI链路带宽是IB的2倍--400 vs 200 Gbit/s,不过系统速度较难判断。在TensorFlow图片操作水平上我们基于一个内部事件驱动的模拟器来评估一个混合ICI/IB网络。(它忽略了非常重要的CPU上的协议处理)。根据切片的大小,一个优化的all-reduce运行速度将慢1.8倍-2.4倍,而all-to-all的速度将慢1.2倍-2.4倍。由于通信只是训练时间的一部分,IB将拖慢DNN的整体速度有10%左右。

然而,最大的影响还是在第二节中提到的OCS带来的优势:可用性、规模、利用率、模块化、电源效率、可部署性等等。

对谷歌最新论文兴趣的同学点赞和在看后,在公众号后台回复“tooyum56”可以获取下载地址。

相关阅读:

P4教程 P4应用

P4可编程SDN交换机

Tofino1 | Tifino 2 |Tofino 3

共谋信创 国产平台汇聚分流器

基于可编程交换机的网络仿真平台