在斯坦利•库布里克的电影杰作《2001:太空漫游》中,一台名为HAL的先进机载人工智能计算机为宇宙飞船船员提供了关键的更新和基本信息,最终塑造了前往木星的任务轨迹。

这部诞生于半个世纪前的电影至今仍是许多科技人心中的神作。事实上,HAL不是普通的计算机,它是一个完全有感知能力的人工智能系统,可以为机组人员提供实时更新,同时监控和维护航天器的系统,报告系统异常和可能的故障。一个场景中,HAL通知机组人员无线电通信设备很快就会出现故障,而当被要求提供更多信息时,HAL的回应堪称教科书般完整、清晰且权威。

为什么会看到这些?请解释一下

当下,人工智能系统的感知能力远不如HAL。不过,人工智能已经具备特定能力,足以监控和评估企业活动,帮助检测财务欺诈。

例如,负责检测欺诈的员工越来越依赖人工智能和机器学习来检测电子邮件通信中的异常情况。

但欺诈警报本身还不够。当审核者收到建议时,更需要了解人工智能是如何得出该结论的。简而言之,他需要完全保证人工智能的准确性和正确性。

Veritas高级首席产品经理Chris Stapenhurst表示:“机器学习和人工智能的下一场革命将是可解释性。审核者需要了解人工智能引擎为何以及如何做出决定。”

当摆在面前的是由人工智能标记的数十封电子邮件中的危险信号列表时,显然,审核者需要知道这些结果背后的原因,合理性需要得到解释。

人工智能会检测主题行或电子邮件内容中的某些词汇,从而产生相关性。但是,不仅仅是关键字,它还考虑元数据属性,例如消息方向和参与者,并接收来自基于自然语言处理相关元素(例如情感分析)的潜在贡献。

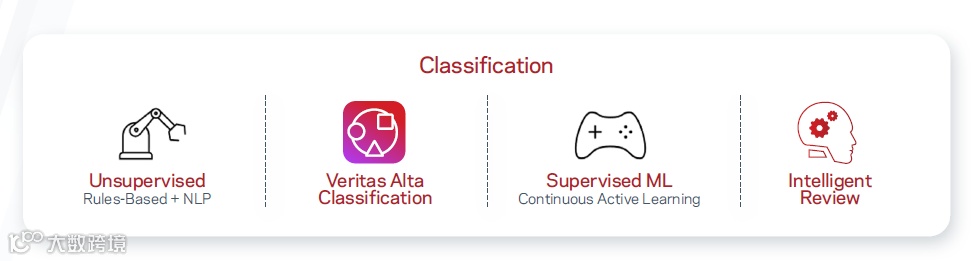

系统可以涵盖一个精心设计、功能强大的分类引擎,并提供开箱即用的专家预训练模型,以轻松识别金融欺诈等场景。

机器学习引擎充分利用内置标签集,将其视为贡献元素,协助支持输入预测。这种类型的系统通常被认为是增强人工智能,即人工智能加上人类交互。

它学会预测哪些项目可能与带有特定标签(例如涉嫌洗钱)的审核者相关,甚至可以接受审核者直接提交的关键词和短语,以增强其学习能力,充实项目审核过程。

透明度创造信任

当福尔摩斯开始说出那句经典的“亲爱的华生”时,他终于确定了破案结论的来源。这位不可思议的天才通过戏剧性的华丽表演让读者一直蒙在鼓里,直到故事结束。

事实上,福尔摩斯正是透明度的典型代表,只不过是让读者等到故事结束,才能理解他的推理。

这也是审核者完成工作所需的过程。重点并不在于等待结果本身,那一刻他只需要相信人工智能。

求证,获取明确的解释,透明度是正解。

通过单一视图提供值得信赖的透明度

Veritas的AI系统为审核平台提供单一视图。它为每个项目分配相关性分数,并详细解释人工智能系统为何认为其相关。

这包括特定用户的参与度、主题和内容中的关键词以及分类标签等。

该系统还可显示导致无关性的因素,帮助节省时间,提高效率,方便审核者和管理人员深入了解决策。这种方法不仅帮助使用者充分建立对人工智能系统的信任度,而且还准确地传达了审核者应该关注的消息元素。

Veritas还在其分类引擎中提供透明的策略,允许审核者公开访问和修改决策逻辑和参数。

Stapenhurst强调,Veritas提供的AI和ML工具不仅限于电子邮件监控,还可以应用于各种形式的数字化内容,包括短信、聊天、音频和视频等。

持续主动学习(CAL)方法则让系统能够适应新信息并确保不同数据源的准确性。

透明度带来有意义的理解,理解带来应用。过程循环往复,一直在线,时刻学习,不断精进。

当人工智能来到福尔摩斯身边,我们获得真相,更赢得信任和尊重。

而谁又是助你成为福尔摩斯的那个得力助手呢?