极市导读

本文带你了解ObjectRelator:一个专门解决第一人称(Ego)与第三人称(Exo)视角之间物体对应难题的新框架。它通过引入多模态条件融合和跨视角对象对齐两大创新模块,显著提升了跨视角物体定位与分割的准确性,在实际测试中效果大幅超越现有方法。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

在计算机视觉中,如何连接第一人称视角(ego-centric, 如佩戴者视角)和第三人称视角(exo-centric, 如旁观者或上帝视角)一直是个长期存在的难题。本文介绍的这篇论文 “ObjectRelator: Enabling Cross-View Object Relation Understanding Across Ego-Centric and Exo-Centric Perspectives”,就针对这一前沿挑战提出了一个全新的解决方案。

该论文聚焦于一个新兴的任务:Ego-Exo 物体对应(Ego-Exo Object Correspondence)。简单来说,就是给定一个物体在第一人称(Ego)视角视频中的样子(例如,一个戴着摄像头的厨师看到的某个碗),模型需要在第三人称(Exo)视角的视频中准确地找到并分割出同一个碗。这项技术对于虚拟现实(VR)、机器人技术(如通过观察演示来学习操作)等领域具有巨大的应用潜力。

论文提出的 ObjectRelator 框架,通过两大创新模块,有效解决了第一和第三人称视角之间因剧烈视角变化、物体外观差异和复杂背景干扰导致的目标定位与分割难题,在大型基准测试中取得了当前最佳(SOTA)性能。

-

论文标题:ObjectRelator: Enabling Cross-View Object Relation Understanding Across Ego-Centric and Exo-Centric Perspectives -

作者:Yuqian Fu, Runze Wang, Bin Ren, Guolei Sun, Biao Gong, Yanwei Fu, Danda Pani Paudel, Xuanjing Huang, Luc Van Gool -

机构:INSAIT, 索非亚大学, 复旦大学, 特伦托大学, 比萨大学, 苏黎世联邦理工学院, 蚂蚁集团 -

论文链接:https://arxiv.org/abs/2405.19083 -

项目主页:http://yuqianfu.com/ObjectRelator

01 研究背景:第一人称与第三人称的“隔阂”

尽管现有的分割模型层出不穷,但它们大多在单一视角下工作,难以应对跨视角物体关联的挑战。最近提出的PSALM模型虽然在该任务上展示了零样本(zero-shot)学习的能力,但由于Ego和Exo视角之间存在巨大的差异,PSALM在精确定位和分割物体时仍然会遇到困难,尤其是在背景复杂或物体外观变化显著的情况下。

具体挑战如下:

-

视角剧变:第一人称视角通常视野较窄、物体较大且可能不完整;而第三人称视角视野开阔、物体较小且背景复杂。同一个物体在两个视角下的形状、大小和姿态可能完全不同。 -

外观变化:光照、遮挡等因素会导致物体在不同视角下的外观(颜色、纹理)产生显著差异。 -

背景干扰:第三人称视角中可能包含大量与目标物体相似的干扰物,导致模型错误分割。

02 ObjectRelator:跨视角物体关联的新方法

为了克服以上困难,研究者们在PSALM基线模型的基础上,提出了 ObjectRelator。该框架引入了两个核心模块:多模态条件融合(Multimodal Condition Fusion, MC-Fuse) 和 基于自监督学习的跨视角对象对齐(SSL-based Cross-View Object Alignment, XObjAlign)。

整体架构

ObjectRelator的整体框架如下图所示。它以PSALM(粉色块)为基础,输入一个查询视角(如Ego视图)的图像和物体掩码(mask),以及一个目标视角(如Exo视图)的图像。其目标是在目标视角中预测出对应物体的掩码。创新的MC-Fuse(橙色)和XObjAlign(绿色)模块是实现精确关联的关键。

多模态条件融合 (MC-Fuse)

为了解决仅靠视觉掩码不足以区分相似物体的问题,MC-Fuse 模块 首次将自然语言描述引入到该任务中。它首先利用一个强大的视觉语言模型(如LLaVA)为查询物体生成文本描述(例如“一个篮球”)。然后,通过一个轻量级的交叉注意力机制,将视觉掩码提示和文本描述提示进行融合。

这种多模态输入的策略,使得模型能够同时利用物体的视觉特征和语义信息,从而更准确地锁定目标,避免与背景中的干扰物混淆。

跨视角对象对齐 (XObjAlign)

为了增强模型对物体外观变化的鲁棒性,XObjAlign 模块采用了一种自监督学习策略。其核心思想是:同一个物体,无论在哪个视角下,其高级特征表示(embedding)应该尽可能相似。

具体来说,该模块在训练过程中,会同时提取查询物体在Ego视角下的特征和它在Exo视角下的真实特征,并通过一个一致性损失函数(如欧氏距离)来拉近这两个特征向量的距离。这种方式强制模型学习一种视角不变的物体表示,从而能够更好地处理因视角变化导致的外观差异。

03 实验与结果分析

论文在两个大规模数据集上验证了ObjectRelator的有效性:Ego-Exo4D 和一个新构建的、适用于机器人操作的 HANDAL-X 数据集。

主要结果

实验结果表明,ObjectRelator在各项指标上均显著优于包括PSALM在内的所有基线方法。例如,在Ego-Exo4D数据集上,相比于PSALM,ObjectRelator在Ego2Exo任务上的IoU提升了 4.6% (44.3 vs 39.7),在Exo2Ego任务上提升了 5.1% (49.2 vs 44.1)。

消融研究

为了验证每个模块的贡献,论文进行了详细的消融实验。结果证明,单独加入MC-Fuse或XObjAlign模块都能带来明显的性能提升,而将两者结合使用时效果最好,证明了两个模块的有效性和兼容性。

进一步的分析还表明,即使在测试时没有文本输入,经过多模态训练的ObjectRelator性能仅有轻微下降,依然远超基线模型,显示了其良好的鲁棒性。

更多的消融实验也验证了模型设计中各个细节的合理性。

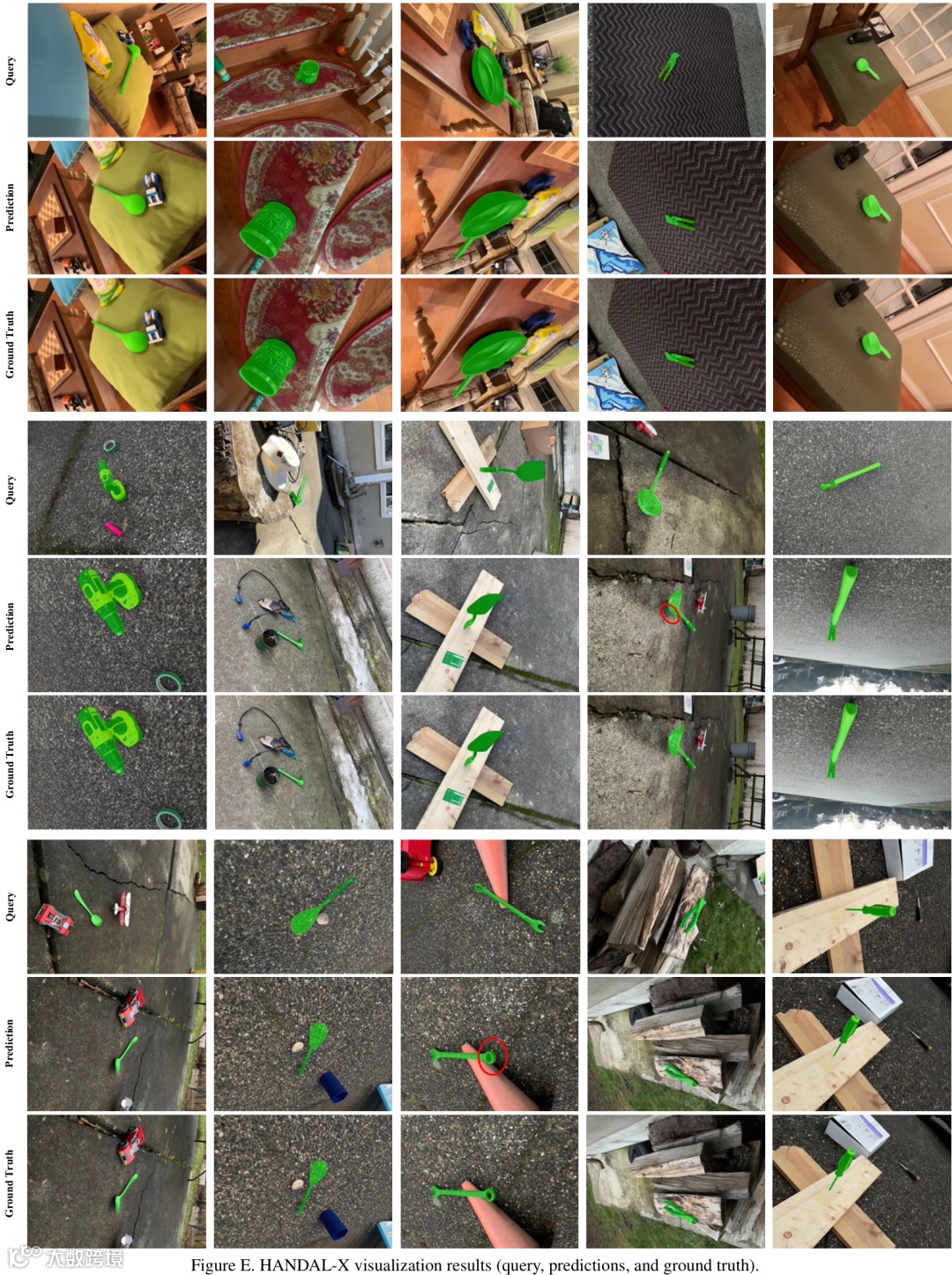

可视化结果

可视化结果直观地展示了ObjectRelator的优势。在PSALM模型会因为背景中存在形状相似物体而分割错误的情况下,ObjectRelator借助文本描述可以准确识别并分割出正确的目标。

在各种复杂的室内外场景中,ObjectRelator都能成功地在不同视角之间关联物体,即使物体发生严重形变、尺寸变化或部分遮挡。

当然,模型也存在一些失败案例,例如当物体表面不连续或与背景融为一体时,分割效果会打折扣。

以下是更多的可视化结果。

04 总结与贡献

ObjectRelator作为对Ego-Exo物体对应任务的早期探索,其贡献是多方面的:

-

深入分析了任务挑战:对这一新兴任务的独特困难进行了分析,并构建了多个基线模型。 -

提出了创新框架:设计了ObjectRelator框架,其两大核心模块MC-Fuse和XObjAlign分别从引入额外语义信息和加强视角一致性两个角度,有效地提升了模型的性能。 -

树立了新的SOTA:在Ego-Exo4D和HANDAL-X两个数据集上均取得了当前最优结果,为后续研究提供了强有力的基准。

公众号后台回复“数据集”获取100+深度学习各方向资源整理

极市干货

点击阅读原文进入CV社区

收获更多技术干货