极市导读

RoMa v2 用 DINOv3 + 单头注意粗匹配 + CUDA 精修,10 数据集训练 + EMA 去亚像素偏置,640×640 吞吐 30.9 pair/s,MegaDepth/ScanNet 位姿 AUC 全面领先,并输出逐像素协方差,代码已开源。>>加入极市CV技术交流群,走在计算机视觉的最前沿

大家好,今天想和大家聊一篇关于特征匹配的新工作,来自瑞典林雪平大学等知名高校的研究团队。他们推出的 RoMa v2,可以说是给密集特征匹配这个领域又打了一针“强心剂”,目标非常明确,就是要“Harder, Better, Faster, Denser”。

密集特征匹配,简单来说,就是想办法在两张不同视角、甚至不同光照下拍摄的图片之间,为每一个像素点都找到它对应的“另一半”。这门技术是三维重建、视觉定位等众多应用的基础,重要性不言而喻。但长久以来,大家都在“精度”和“速度”之间做着艰难的取舍。有些模型精度高,但跑起来又慢又吃显存;有些跑得快,但在复杂场景下又容易“翻车”。

而 RoMa v2 就像一位全能选手,试图打破这个僵局。它不仅在精度上树立了新的SOTA(State-of-the-Art,即当前最佳水平),在运行速度和效率上也有了质的飞跃。

-

论文标题: RoMa v2: Harder Better Faster Denser Feature Matching -

作者: Johan Edstedt, David Nordström, Yushan Zhang, Georg Bökman, Jonathan Astermark, Viktor Larsson, Anders Heyden, Fredrik Kahl, Mårten Wadenbäck, Michael Felsberg -

机构: 林雪平大学、查尔姆斯理工大学、阿姆斯特丹大学、隆德大学 -

论文地址: https://arxiv.org/abs/2511.15706 -

代码仓库(已开源,星标快速上升中): https://github.com/Parskatt/romav2

下面我们来看看,RoMa v2 究竟是如何做到这一切的。 从这张性能雷达图就能直观感受到 RoMa v2 的全面领先,它在一系列位姿估计和密集匹配的基准测试中都表现出色。

从这张性能雷达图就能直观感受到 RoMa v2 的全面领先,它在一系列位姿估计和密集匹配的基准测试中都表现出色。

01 背景:在速度与精度的权衡中寻求突破

在 RoMa v2 之前,密集匹配领域有几位“明星选手”。比如它的前身 RoMa,通过引入冻结的视觉基础模型(Foundation Model)特征,在应对剧烈光照和模态变化时表现得非常鲁棒,但缺点是速度慢、计算开销大。另一位选手 UFM 则另辟蹊径,实现了更快的匹配速度,但在需要亚像素级精度的任务上,以及在某些极端外观变化的数据集上(如 WxBS),表现就不如 RoMa。

这就形成了一个两难的局面:我们想要一个既能像 RoMa 那样应对各种“魔鬼”场景“从从容容”,又能像 UFM 那样跑得飞快“游刃有余”。RoMa v2 的研究动机,正是要将二者的优点结合起来,打造一个既鲁棒又高效的全能匹配器。

上图展示了 RoMa v2 在各种真实世界场景下的定性匹配结果,从宽基线、动态物体到光照变化,它都能准确地建立像素级的对应关系。图中每个像素的颜色来自另一张图中对应位置的RGB值,颜色越亮表示模型对该匹配的置信度越低。

02 方法:RoMa v2 的“独门秘籍”

RoMa v2 并非简单地修修补补,而是一次系统性的全面升级。其核心在于一个全新的 两阶段匹配-精调(matching-then-refinement) 架构,并在一系列关键技术点上进行了创新。

上图是 RoMa v2 的整体架构概览。输入两张图片 和 ,模型会经过一个粗匹配(Coarse Matcher)和一个精调器(Refiners)两个阶段,最终输出双向的密集匹配场(Warp)和置信度图(Confidence)。值得注意的是,它还创新性地输出了一个**逐像素的协方差矩阵 **,这为下游任务提供了宝贵的不确定性信息。

2.1 更强的粗匹配器:DINOv3 与新架构的强强联合

粗匹配阶段的目标是快速建立一个大致准确的对应关系。

-

拥抱 DINOv3: RoMa v2 将特征提取器从 DINOv2 升级到了更新、更强的 DINOv3。实验证明(如下表所示),冻结的 DINOv3 特征在匹配任务中具有更强的鲁棒性。

-

全新的匹配架构: 作者发现 RoMa 中的高斯过程(GP)回归虽然有一定作用,但梯度信息不足,影响了多视图上下文的学习。因此,RoMa v2 大胆地用一个简单的 单头注意力机制 替换了高斯过程,并引入了一个基于负对数似然(Negative Log-Likelihood)的辅助损失 。

这个损失函数的目标是,对于图像A中的每个块(patch),最大化其在图像B中正确匹配块的概率。这种设计,可以看作是 LoFTR 等方法的密集化、有向化版本,它让模型在粗匹配阶段就能更好地利用两张图的全局信息。

上图是粗匹配器的内部结构,它使用一个多视图 Transformer 交替进行帧内和全局的注意力计算,最终输出一个 4 倍下采样分辨率的粗略匹配场。

从下面的对比实验可以看出,RoMa v2 的新匹配架构在 Hypersim 数据集上相比 UFM 的架构,精度(PCK,即正确关键点百分比)实现了碾压性的提升。

2.2 更快更省的精调器:CUDA 内核与架构优化

粗匹配给出了一个大概位置,精调器(Refiner)则负责将匹配精度提升到亚像素级别。

-

定制 CUDA 内核: 作者发现,RoMa 的精调器在计算局部相关性(local correlation)时非常消耗显存。为了解决这个问题,他们手写了一个 定制的 CUDA 内核,在功能不变的前提下,显著降低了高分辨率下的显存占用。 -

架构瘦身: 由于粗匹配的输出分辨率从 stride 14 提升到了 stride 4,精调器也得以简化,只需要在 {4, 2, 1} 三个尺度上进行。同时,网络通道数被调整为2的幂次方,进一步提升了计算效率。

上图展示了精调器的内部结构,它是一个类似 UNet 的网络,输入粗匹配结果,输出全分辨率的精确匹配。

2.3 更聪明的训练策略:多样化数据与 EMA 抗偏置

好的模型离不开好的“教材”。

-

丰富的数据“食谱”: RoMa 只在 MegaDepth 数据集上训练,而 RoMa v2 则采用了包含10个不同数据集的多样化混合训练数据。这份“食谱”既有 MegaDepth、AerialMD 这样的宽基线(wide-baseline)数据集,用于提升模型对大视角变化的鲁棒性;也包含了 FlyingThings3D 这样的小基线(small-baseline)数据集,用于提升对精细动态物体的捕捉能力。

多样化的训练数据带来了肉眼可见的提升。如下图所示,相比 RoMa,RoMa v2 能够更好地捕捉动态小物体的匹配。

-

EMA 消除亚像素偏置: 团队在训练中观察到一个有趣的现象:模型的预测结果会存在一个微小但持续波动的亚像素偏置(subpixel bias)。他们发现这种偏置在训练过程中近似随机,于是想出了一个简单而有效的方法——使用权重的指数移动平均(Exponential Moving Average, EMA)。通过保存一份模型的“慢速更新”版本作为最终模型,成功消除了这种恼人的偏置。

2.4 预测不确定性:像素级协方差估计

这是 RoMa v2 的一个非常亮眼的新特性。除了预测匹配位置,它还能为每个像素测一个 的协方差矩阵,用来量化预测的不确定性。这意味着模型不仅知道“应该匹配到哪里”,还知道自己对这个预测“有多大把握”,以及误差可能出现在哪个方向。

上图直观地展示了协方差的预测效果。在右图中,作者模拟了运动模糊,可以看到模型预测出的协方差(椭圆)也相应地变大,尤其是在模糊的方向上,这说明模型准确地捕捉到了不确定性的增加。这个信息对于下游的位姿估计等任务非常宝贵。

03 实验:全方位制霸各大榜单

RoMa v2 在一系列标准测试集上与当前最先进的方法进行了正面交锋,结果堪称“屠榜”。

3.1 运行效率:速度与内存双优

首先看大家最关心的效率。在 640x640 分辨率下,RoMa v2 的吞吐量达到了 30.9 pairs/s,比 RoMa 快了 1.7 倍,同时内存占用还略有降低。相比 UFM,虽然速度稍慢,但内存占用小得多。

3.2 精度对比:新 SOTA 诞生

-

相对位姿估计: 在 MegaDepth-1500 和 ScanNet-1500 这两个经典的位姿估计基准上,RoMa v2 的精度(以 AUC 指标衡量)均超越了包括 RoMa、UFM、LightGlue 在内的所有对手。

-

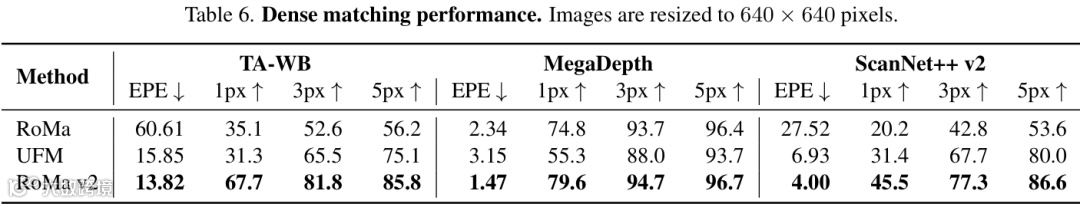

密集匹配精度: 在更考验“像素级”能力的密集匹配任务上,RoMa v2 在 TA-WB、MegaDepth、ScanNet++ 等 6 个数据集上实现了全面领先,无论是平均端点误差(EPE)还是不同像素阈值下的正确率(PCK),都取得了最佳成绩。值得一提的是,它既在 UFM 擅长的 TA-WB 上击败了 UFM,也在 RoMa 的“主场” MegaDepth 上超越了 RoMa。

-

跨模态与新挑战: 在极具挑战性的 WxBS(跨模态、跨视角、跨光照)和作者新推出的 SatAst(宇航员照片对卫星图)基准上,RoMa v2 也表现出了强大的泛化能力。尤其是在 SatAst 上,它以巨大优势领先,展现了在未知领域的强大潜力。

04 总结

总的来说,RoMa v2 通过一系列系统性的改进,成功地在精度、速度和鲁棒性之间找到了一个更优的平衡点,为密集特征匹配树立了新的标杆。特别是协方差预测的引入,为下游任务打开了新的想象空间。

重要的是,作者已经开源了代码,感兴趣的朋友不妨去亲自体验一下这个“更快、更强、更密集”的匹配神器。

公众号后台回复“数据集”获取100+深度学习各方向资源整理

极市干货

点击阅读原文进入CV社区

收获更多技术干货