千里之行,始于足下。Miles 的发布标志着 LMSYS 团队在构建生产级 AI 基础设施道路上迈出的关键一步。

NodeAI Highlights:

True On-Policy(严格在线策略): 为了消除训练与推理之间的微小偏差,Miles 采用了基于基础设施的方法,结合 Flash Attention 3 和 DeepGEMM,实现了训练与推理的严格一致性。

引入 MTP Online Training 的投机采样: 针对 RL 场景,Miles 在训练过程中对 Draft Model 进行在线 SFT,解决了分布偏移问题,实现了 25%+ 的 Rollout 加速。

极致的显存优化: Miles 实施了包括 NCCL 显存余量控制、部分 Offloading 及 Host 峰值内存节省在内的一系列改进,大幅减少大规模 MoE 训练中的 OOM 风险。

从 slime 出发:轻量与模块化的传承

Miles 的起点源于 slime——一个在开源社区与 LMSYS 内部备受推崇的轻量级框架。slime 因其优雅的设计原则,已成为众多模型科学家探索算法的首选工具。Miles 完整继承了这些核心优势:

原生高性能: 对 SGLang 和 Megatron 的全栈优化提供原生支持,紧跟推理与训练框架的快速迭代。

清晰的模块化设计: 算法(Algorithm)、数据(Data)、采样(Rollout)与评估(Eval)四大组件完全解耦。研究人员仅需极少的代码修改即可插入新的 Agent 类型或奖励函数。

对模型科学家友好: 所有抽象层均保持高可读性。算法研究员无需触碰底层代码即可修改重要性采样(Importance Sampling)或 Loss 动态,且框架提供了独立的 Inference-only 和 Training-only 调试模式,便于快速诊断。

Miles 的诞生,正是基于 LMSYS 和 SGLang 社区的真实反馈,是将开放协作转化为工程实践的典范。

迈向生产级:Miles 的核心技术突破

在保留 slime 灵活性的同时,LMSYS 团队在 Miles 中注入了针对企业级应用和新一代硬件(GB300)的“强心剂”。以下是 Miles 近期实施的关键技术升级:

Infrastructure-level 的 True On-Policy

为了追求极致的算法正确性,Miles 除了支持现有的确定性(Deterministic)采样外,还进一步通过 kernel 层面的优化实现了 True On-Policy,训练与推理之间的 mismatch 被精确地降至零。

具体实现上,团队利用了 Flash Attention 3、DeepGEMM 以及来自 Thinking Machines Lab 的 Batch invariant kernels,并结合 torch compile 技术。此外,团队还对训练和推理过程中的数值运算细节进行了严格对齐,确保了结果的位级一致性(bit-wise consistence)。

大规模 MoE 显存优化

为了在不触发 OOM(显存溢出)的前提下最大限度地榨取 GPU 性能,Miles 进行了一系列显存管理升级:

引入了传播机制以规避良性 OOM 导致的错误;

实现了显存余量机制(Memory Margin)以修复 NCCL 导致的 OOM;

修复了 FSDP 中的额外显存占用问题;

支持基于 Move 的部分 Offloading 以及 Host 端峰值内存节省策略。

引入在线 SFT 的投机训练 (Speculative Training)

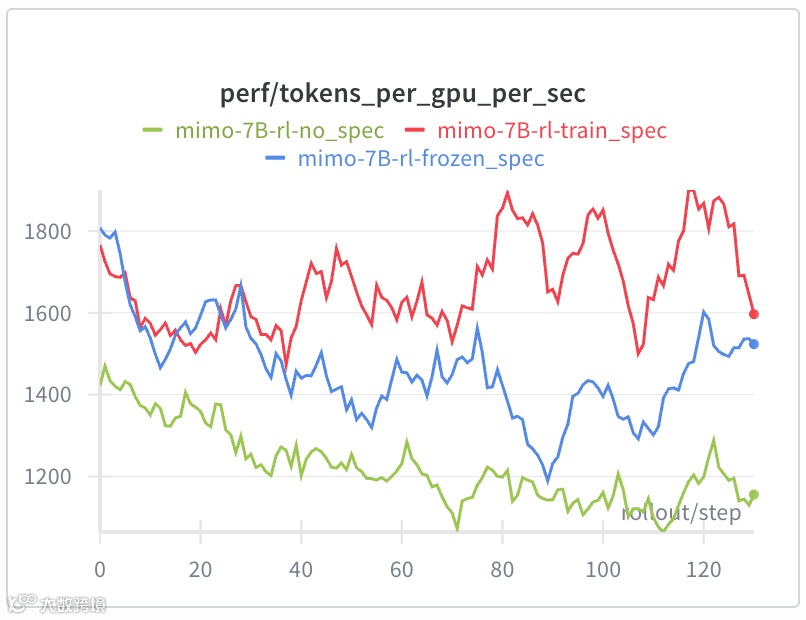

在强化学习场景中,如果 Draft Model(草稿模型)保持冻结,它将无法跟随 Target Model(目标模型)的策略变化,导致接受长度(Accept Length)下降,从而削弱加速效果。

为此,Miles 创新性地在 RL 过程中对 Draft Model 进行在线 SFT(Online SFT)。

性能提升: 相比于冻结 MTP(Medusa-Tree-Pruning)基线,该方法实现了 25% 以上 的 Rollout 加速,尤其在训练后期效果显著。

功能完备: 支持带 Sequence Packing 和 Context Parallel (CP) 的 MTP;处理了 Loss Mask 的边缘情况;实现了 LM Head/Embedding 的梯度隔离,以及 Megatron 与 SGLang 之间的权重同步。

其它工程改进

增强 FSDP 后端: 提升了大规模分布式训练的稳定性。

独立部署 Rollout: 允许 Rollout 子系统脱离框架独立部署,适应更灵活的集群调度。

调试工具集: 新增了更多监控指标、Post-hoc 分析器及增强型 Profiler。

数学形式化验证: 提供了包含 SFT/RL 脚本的 Lean 语言形式化数学示例。

未来路线图与社区愿景

LMSYS 团队表示,Miles 的发布仅仅是一个开始。为了进一步支持企业级 RL 训练,未来的开发路线图包括:

新硬件支持: 在 GB300 等下一代硬件上运行大规模 MoE RL 的示例。

多模态训练: 扩展对 Multi-modal 模型的支持。

Rollout 加速: 兼容 SGLang Spec v2 以获得更高性能;推进 EAGLE3 及 Multi-spec layer 等更先进的投机训练技术。

弹性训练: 实现针对大规模异步训练的计算资源均衡分配,以及对 GPU 故障的弹性容错(Elastic to GPU failures)。

Miles 的存在离不开 slime 作者群及广泛的 SGLang/RL 社区的贡献。LMSYS 团队诚邀研究人员、初创公司及企业团队试用 Miles,共同打造高效、可靠的强化学习生产环境。

https://lmsys.org/blog/2025-11-19-miles/