点击下方卡片,关注“具身智能之心”公众号

作者丨 Jeonguen Park等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

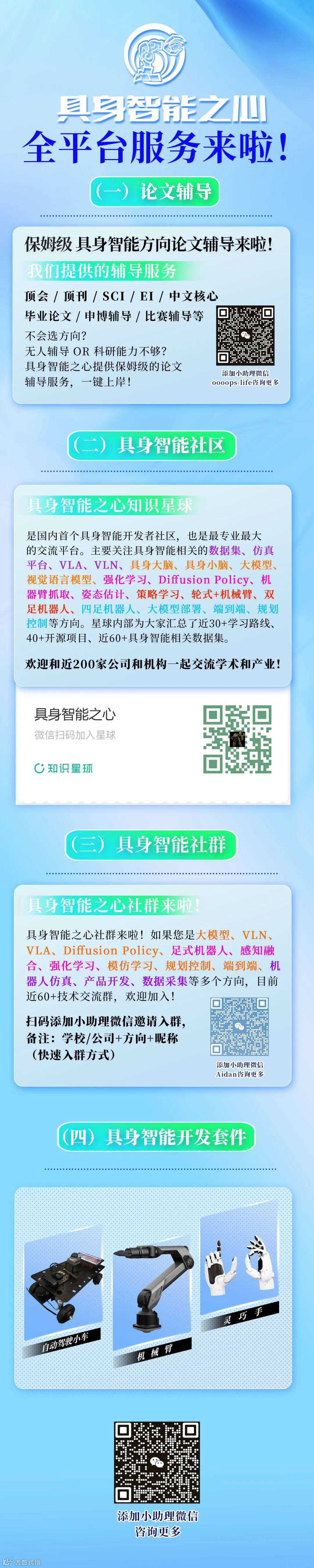

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

研究背景与核心问题

现有VLA模型的局限

视觉-语言-动作(VLA)模型是机器人操作任务的核心技术,传统模型依赖人类遥控收集的成功演示数据训练,但数据采集过程中自然产生的大量失败尝试(如抓取不稳定、碰撞等)常被当作噪声丢弃。这些失败数据蕴含着政策脆弱点的关键信息——揭示了哪些动作序列不可行、哪些场景下容易出错,而单纯依赖成功数据的模型难以应对复杂环境中的不确定性,在未见过的场景中鲁棒性大幅下降。

核心挑战与研究目标

核心挑战在于如何有效整合离线数据中的失败信号:模仿学习(IL)中直接惩罚易失败动作容易扭曲政策,而强化学习(RL)虽能通过奖励信号自然处理失败数据,但需要合适的框架承载。研究目标是构建一个分层VLA模型,将失败经验转化为结构化学习信号,通过显式的规划机制实现“失败感知推理”,在不改变机器人核心技能的前提下,提升复杂操作任务的成功率和鲁棒性。

模型架构:分层VLA框架(VINE)

VINE(Vision–Language–Action model Integrating Negative Experience)基于分层强化学习(HRL)构建,借鉴Kahneman的认知双系统理论,将高层推理与低层控制分离,形成两大核心模块:System 2(推理规划层)和System 1(动作执行层),整体架构如figure2所示。

核心设计理念

-

分层解耦:高层专注“做什么”(可行性规划),低层专注“怎么做”(动作执行),失败信号仅注入高层规划,不干扰底层核心技能。 -

失败感知:通过失败数据训练价值函数,让规划过程能预判高风险路径并提前剪枝。 -

离线训练:无需在线交互,完全基于离线遥控数据(含成功与失败轨迹)训练,落地成本低。

关键技术细节

问题形式化:基于SMDP的分层建模

模型将机器人与环境的交互抽象为半马尔可夫决策过程(SMDP):

-

低层:标准马尔可夫决策过程(MDP),状态包含图像和本体感受,动作是连续控制指令。 -

高层:抽象后的节点(node)和边(edge)构成SMDP,节点是2D场景图(抽象世界状态),边是子目标(状态转移)。 -

目标函数:定义“到达-避免”目标,即优先到达目标集G(成功),避免进入失败集F(不可恢复状态),终止条件为首次进入G或F,奖励函数为稀疏终端奖励(成功时r=1,否则r=0)。

System 2:失败感知的树搜索规划

System 2作为元控制器,通过树搜索实现可行性导向的规划,核心组件包括三部分:

-

世界模型与候选生成

-

节点(状态抽象):通过Grounding DINO检测目标框,结合Gemini-2.5-Flash生成2D场景图,编码物体、空间关系和语义信息,实现状态的紧凑表示。 -

边(子目标生成):通过语言建模头自回归生成子目标(如“拿起勺子”),并通过束搜索和场景图一致性校验,确保生成的子目标符合任务语境。 -

失败感知价值函数

价值函数V(n)估算从节点n出发,先到达G再到达F的概率,公式如下:

其中 和 分别是到达目标集和失败集的首次击中时间。该函数通过成功和失败数据联合训练,采用非对称期望损失(IQL启发)避免价值高估,确保对失败路径的敏感。

-

树搜索算法

采用批量蒙特卡洛树搜索(MCTS),核心逻辑如Algorithm 1所示:

-

每次迭代选择前B个高价值前沿节点,生成k个候选子目标; -

用价值函数评分候选节点,更新路径价值(Q值); -

迭代M次后,选择通往最高价值叶子节点的路径作为规划结果。

该过程通过失败数据训练的价值函数剪枝脆弱分支,优先选择高可行性路径。

System 1:子目标驱动的动作执行

System 1负责将高层规划的子目标序列转化为连续控制动作,仅基于成功数据训练,核心组件包括:

-

动作生成:采用流匹配模型,生成高频率动作块(action chunks),适应20Hz的控制需求,公式为:

其中 是含噪声的动作, 是预测的流场,u是目标速度。

-

终止检测:通过焦点损失训练终止头,判断子目标是否完成,当终止概率超过阈值 时,切换到下一个子目标。

模型融合与训练

-

共享backbone:基于 的多模态backbone,融合PaliGemma语言模型,通过LoRA适配器实现参数高效微调,共享感知-语言表示但解耦推理与控制。

-

分层数据集:System 2使用 形式的高层数据,System 1使用 形式的低层动作数据。

实验验证

实验设置

-

环境:仿真环境(插头插入、抽屉打包)和真实环境(海绵/毛巾收纳),均设置“见过”(训练集配置)和“未见过”(新配置、新物体)场景,如figure3、figure8所示。

-

数据集:人类遥控轨迹,含成功与失败标注,插头插入450条、抽屉打包240条、真实环境100条。 -

基线:统一VLA模型(OpenVLA-OFT、GR00T N1.5、 )、VLM作为规划器(GPT-4o、Gemini-2.5-Flash)、VINE变体(无树搜索、无失败数据)。

核心结果

-

仿真实验(table1)

-

插头插入任务:VINE在未见过场景中成功率达0.422,比最佳基线(GPT-4o)提升26.7%;平均成功率0.611,领先所有基线。 -

抽屉打包任务:未见过场景成功率0.675,比GPT-4o(含失败示例)提升17.4%;平均成功率0.752,相对提升10.1%。 -

变体分析:树搜索和失败数据均为关键——无树搜索的VINE-Chain未见过场景成功率仅0.244,无失败数据的VINE-Tree提升至0.525,而两者结合的VINE-Full达到0.675。

-

测试时扩展性(figure6)

调整规划器每步扩展宽度K(候选子目标数量),未见过场景的成功率随K增加而提升(K=4时达0.444), latency呈线性增长,体现“计算-精度”的良性权衡。

-

真实世界实验(table3)

-

见过场景:海绵收纳成功率0.75,毛巾收纳0.55,均优于 (0.60、0.45)。 -

未见过场景:海绵收纳0.65,毛巾收纳0.55,大幅领先 (0.55、0.30),尤其在物体属性变化时鲁棒性突出。

-

定性结果(figure4、figure9)

-

抽屉打包任务中,基线模型直接尝试放置物体导致碰撞,而VINE规划“移开障碍物→放置→关闭”的多步路径。 -

真实毛巾收纳中,模型优先选择“折叠→放入→关闭”策略,因预测该路径成功率更高。

消融实验

-

树搜索算法:MCTS比DFS在未见过场景成功率高3.1%,且 latency减少9.7秒(figure15)。

-

backbone融合: 与PaliGemma的插值权重λₘ=0.6时性能最优,见过场景成功率0.800,未见过0.422(table5),证明动作先验与语言推理的平衡重要性。

-

重规划模块:添加不确定性触发的重规划后,抽屉打包未见过场景成功率从0.675提升至0.740(figure10),缓解了执行过程中的状态漂移问题。

讨论与局限

核心优势

-

失败数据的有效利用:将失败从“噪声”转化为“可行性约束”,通过价值函数直接指导规划,大幅提升泛化能力。 -

分层架构的灵活性:高层规划可通过调整搜索宽度适应任务复杂度,低层执行保持稳定,无需全模型重训。 -

离线训练的实用性:完全基于现有遥控数据,无需在线交互,降低机器人部署的安全风险和成本。

现存局限

-

缺乏实时反馈:规划在子目标粒度进行,执行过程中无中途反馈,动态场景中可能积累误差。 -

低层控制器偏保守:仅用成功数据训练,难以应对执行中的扰动和偏差。 -

状态抽象不足:2D场景图忽略几何度量、接触力等信息,在遮挡或摩擦主导的任务中可能误判可行性。

改进方向

-

引入不确定性监测的实时重规划(已初步验证有效性)。 -

结合失败数据微调低层控制器,提升容错能力。 -

增强状态表示,融入3D几何和接触动态信息。

核心贡献

-

提出融合失败经验的分层VLA框架,通过HRL实现推理与执行的解耦,首次将失败数据作为结构化规划信号。 -

设计基于2D场景图和树搜索的失败感知规划器,通过价值函数量化路径可行性,实现前瞻性风险规避。 -

仿真与真实环境的全面验证,证明失败数据和分层推理对提升鲁棒性的关键作用,为VLA模型从“广泛胜任”走向“稳健执行”提供新范式。

参考:

[1]Hierarchical Vision Language Action Model Using Success and Failure Demonstrations