OmniAvatar:“全能”的数字人视频生成。OmniAvatar 是一个基于LoRA的高效的音频驱动全身人像视频生成系统,支持从音频 + 单张图像 + 提示语生成自然、表达丰富的视频,仅需一条音频就可以让照片说话,还能用文本加强控制,适应各种场景的视频。代码和模型已开源,欢迎大家体验。

📄 OmniAvatar 论文精读

论文题目:OmniAvatar: Efficient Audio-Driven Avatar Video Generation with Adaptive Body Animation

作者:Qijun Gan, Ruizi Yang, Jianke Zhu (Zhejiang University), Shaofei Xue, Steven Hoi (Alibaba Group)

链接:arXiv:2506.18866v1

主页:https://omni-avatar.github.io/

Code:https://github.com/Omni-Avatar/OmniAvatar

🧠 背景与动机

近年来,音频驱动的人像视频生成广泛应用于虚拟助手、数字人、影视制作等领域。然而,大多数方法仅关注面部表情(如嘴型驱动),忽略了自然的身体动作与场景交互,限制了在动态交互场景中的应用。此外,当前模型在音频与文本提示融合控制方面精度不足,缺乏灵活性。

存在的主要问题:

• 仅面部驱动,无法生成协调的全身动作。

• 音频与视频的对齐(lip-sync)精度不高。

• 对提示文本(prompt)的响应能力有限,难以细粒度控制动作或场景。

🏗 方法简介:OmniAvatar

OmniAvatar 是一个基于LoRA的高效的音频驱动全身人像视频生成系统,支持从音频 + 单张图像 + 提示语生成自然、表达丰富的视频。

方法框架:

关键技术点:

1. Pixel-wise 多层级音频嵌入(Multi-Hierarchical Audio Embedding)

• 使用 Wav2Vec2 提取音频特征,并设计 Audio Pack 模块将其压缩对齐至视频 latent 空间。

Audio Pack :

• 先前的方法多用cross-attention将音频特征嵌入latents,而OmniAvatar在多个层级以逐像素方式嵌入音频信息,强化嘴型同步与整体身体动作关联性。

2. LoRA 微调

• 利用LoRA仅微调部分注意力与前馈层,实现高效模型适配。

• 避免了全量微调导致过拟合或冻结底座模型导致表达不足的问题。

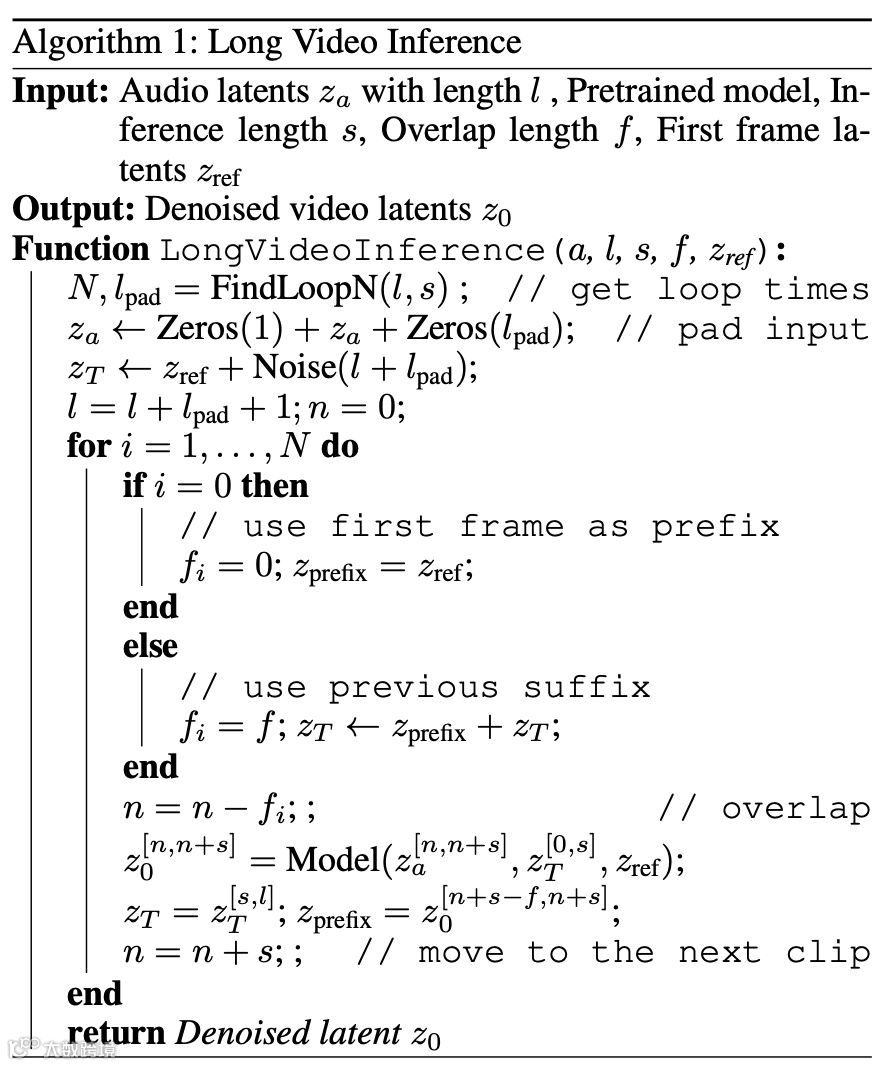

3. 长视频生成机制

• 引入参考图像 latent 作为身份锚定,结合帧重叠策略确保视频连贯性与身份一致性。

• 提出递进式帧段生成算法(如 Algorithm 1)以支持长视频连续输出。

Algorithm 1:

🔬 实验与评估

数据集:

• 训练数据:精滤后的 AVSpeech(1320 小时,约 77 万条短视频)。

• 测试数据:HDTF(高质量人脸视频)+ AVSpeech 测试集(人脸 & 半身)。

评价指标:

• 图像质量:FID、IQA、ASE

• 视频质量:FVD

• 音视频同步精度:Sync-C(相关性↑)、Sync-D(距离↓)

结果摘要:

Talking face:

Body:

• 综合性能领先:在嘴型同步(Sync-C)和图像质量(FID、IQA)上取得领先。

• 半身动画能力更强:与 HunyuanAvatar、FantasyTalking 等相比,OmniAvatar 展现出更自然流畅的动作。

🔍 消融实验

• 验证 LoRA 效果优越:兼顾训练效率与生成质量。

• **多层嵌入优于单层(SHE)**:更好捕捉时间与语义层次。

• 不同CFG带来的影响

• 不同模型大小下的性能

🎥 案例展示与应用能力

• 表情控制(愤怒/高兴/惊讶)

• 手势与物体交互(如“举起水杯”)

• 背景动态控制

• 风格迁移(卡通、油画等)

⚠ 限制与未来方向

• 继承底座模型 Wan 的长视频问题(颜色漂移、误差积累)。

• 多角色交互控制、说话人识别能力仍有限。

• 推理延时偏高,难以满足实时需求。

✅ 总结

OmniAvatar 是一款结合文本与音频提示、支持自然全身动画的音频驱动视频生成模型。通过多层级音频嵌入和 LoRA 微调设计,该方法在生成质量、嘴型同步与控制能力方面均达到了 SOTA 水平,适用于播客、虚拟人、交互场景等多种应用。

🔗 官方项目主页:https://omni-avatar.github.io

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、Stable Diffusion、Sora等相关技术,欢迎一起交流学习💗~