Video4Edit团队投稿|量子位 QbitAI

图像编辑面临训练数据稀缺难题。百度研究人员提出新思路:将图像编辑视为退化的时间过程(Degenerate Temporal Process),从视频中挖掘无监督时序信息,实现高效知识迁移。

Video4Edit利用视频预训练模型中的单帧演化先验(Single-Frame Evolution Prior),仅需主流编辑模型约1%的监督数据,即可达到当前第一梯队模型的性能水平。

当前的「数据稀缺」与「权衡困境」

现有基于扩散模型的图像编辑方法高度依赖大规模高质量三元组数据(指令-源图像-编辑后图像),采集成本高、覆盖意图有限[2]。

模型在结构保持(Structure Preservation)与纹理修改(Texture Modification)之间存在根本性权衡:强调结构易削弱编辑自由度,追求语义变化又易引发几何失真[2]。

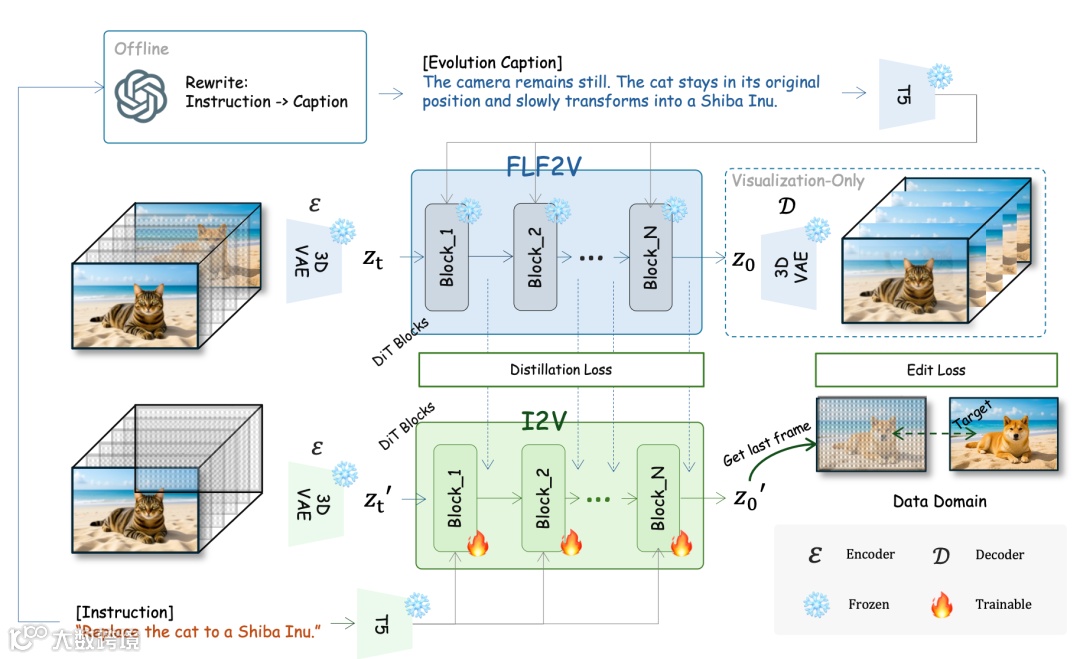

Video4Edit将图像编辑重新定义为视频生成的特殊退化形式——即把源图像视作第0帧、编辑结果视作第1帧,建模为一个2帧极短视频生成过程[2]。

该视角支持从海量视频中自动抽取成对帧作为无监督训练样本,大幅提升数据规模,从而缓解结构—纹理权衡问题,使模型在充分经验基础上实现“从心所欲而不逾矩”的编辑效果[2]。

从「灵光一现」到「工程实现」

团队依托视频预训练模型中蕴含的单帧演化先验(Single-Frame Evolution Prior)。该先验在大量视频上习得时序一致性与帧间演化规律,天然融合结构稳定性与语义可变性[3]。

1. 时间退化建模

将编辑过程建模为t=0(源图像)→t=1(编辑后图像)的时序演化。原需显式学习的结构保持约束,由此转化为视频生成中成熟的时序注意力机制(Temporal Attention),该机制天然维持相邻帧间的高频细节与几何结构[3]。

2. 先验知识迁移

在潜在空间(Latent Space)中,视频模型学习的zt→zt+1转移概率分布,可通过文本指令进行条件化引导,将通用时序演化能力定向适配至特定编辑意图[3]。模型主要学习意图对齐,无需从零重建图像生成能力,显著提升参数复用效率[3]。

3. 数据效率分析

引入视频先验显著降低假设空间熵,增强泛化能力[3]。相比静态图像对学习复杂非线性映射,基于时序演化的微调具备更高样本效率,解释了其仅需约1%监督数据即可收敛的原因[3]。

效果展示

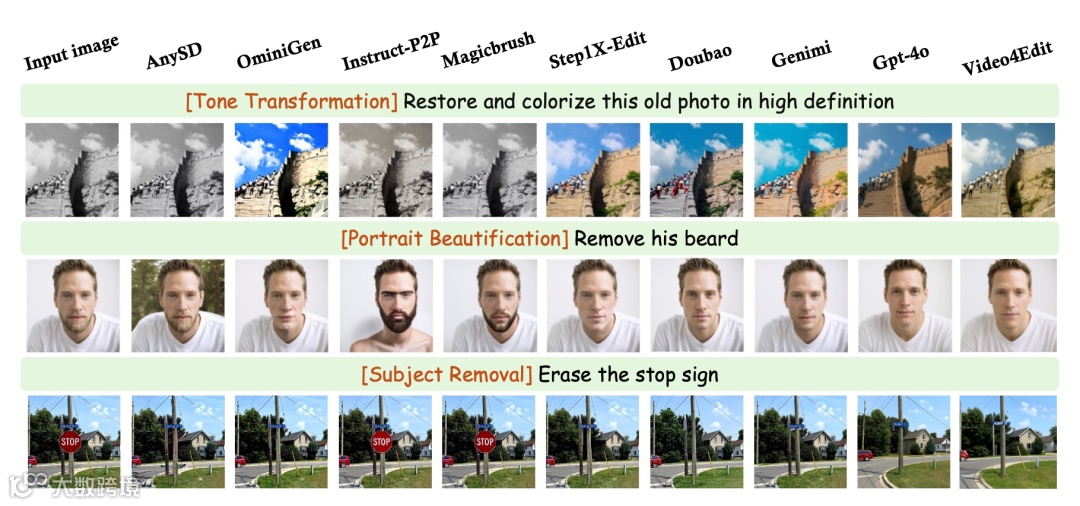

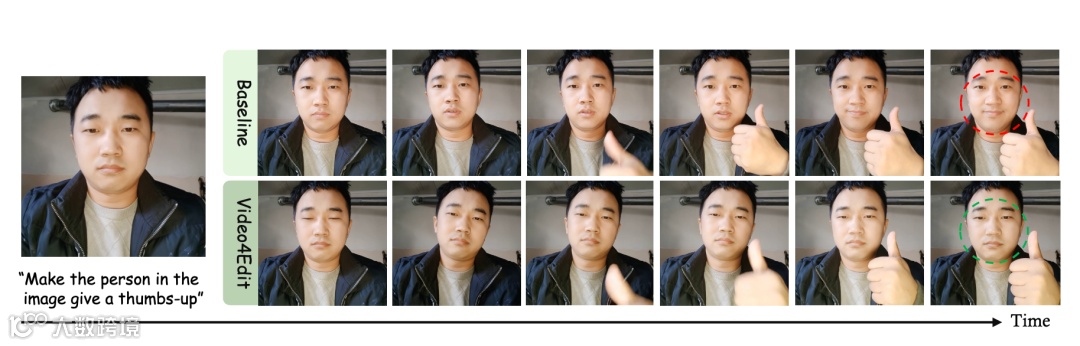

Video4Edit在风格迁移(Style Transfer)、物体替换(Object Replacement)、属性修改(Attribute Modification)等任务中系统验证效果[4]。

Instruction: Replace the text ‘TRAIN’ with ‘PLANE’.

Instruction: Restore and colorize this old photo in high definition.

Instruction: Remove his beard.

Instruction: Replace background with snowy mountain.

Instruction: Erase the stop sign.

Instruction: Transform to sketch style.

在风格迁移中,能精准捕捉目标风格(如油画、赛博朋克),同时保留源图结构;在物体替换中(如“猫→狗”或车辆换色),实现自然语义融合与高质量边缘处理,伪影极少[4]。

对复杂自然语言指令理解准确,表明单帧演化先验在语义对齐方面具备良好泛化能力[4]。

用百分之一的“教材”,交出满分答卷

在标准评估协议下,Video4Edit监督数据量仅为MagicEdit等基线方法的1%,但在CLIP Score(语义对齐质量)和Structure Score(结构保持能力)等关键指标上达到相当甚至更优水平[5]。

这验证了视频预训练先验可大幅降低监督数据依赖,同时保障高质量编辑输出[5]。相较传统依赖大规模标注的方法,Video4Edit提供了一种更经济、更可扩展的图像编辑训练范式[5]。

论文题目:Video4Edit: Viewing Image Editing as a Degenerate Temporal Process

arXiv链接:https://arxiv.org/abs/2511.18131

项目主页:https://shalfun.github.io/video4edit/