点击上方蓝字关注我们

🔍 本文的创新点主要体现在以下三个方面:

提出动态局部-全局特征融合注意力机制(DLGA):通过双路径动态融合策略,有效解决复杂水下环境中被遮挡小目标特征丢失的难题。

设计轻量化双路径通道重排模块(DPC):采用特征分割与通道重组技术,显著缓解密集区域海洋生物个体间的特征混淆问题。

引入跨尺度特征融合结构(CCFF):在提升模型对模糊低对比度图像识别能力的同时,大幅降低计算复杂度,实现了检测精度与轻量化性能的有效平衡。

博主简介

AI小怪兽 | 计算机视觉布道者 | 视觉检测领域创新者

深耕计算机视觉与深度学习领域,专注于视觉检测前沿技术的探索与突破。长期致力于YOLO系列算法的结构性创新、性能极限优化与工业级落地实践,旨在打通从学术研究到产业应用的最后一公里。

🚀 核心专长与技术创新

YOLO算法结构性创新:于CSDN平台原创发布《YOLOv13魔术师》、《YOLOv12魔术师》等全系列深度专栏。系统性提出并开源了多项原创自研模块,在模型轻量化设计、多维度注意力机制融合、特征金字塔重构等关键方向完成了一系列突破性实践,为行业提供了具备高参考价值的技术路径与完整解决方案。

技术生态建设与知识传播:独立运营 “计算机视觉大作战” 公众号(粉丝1.6万),成功构建高质量的技术交流社群。致力于将复杂算法转化为通俗易懂的解读与可复现的工程代码,显著降低了计算机视觉的技术入门门槛。

🏆 行业影响力与商业实践

荣获腾讯云年度影响力作者与创作之星奖项,内容质量与专业性获行业权威平台认证。

全网累计拥有 7万+ 垂直领域技术受众,专栏文章总阅读量突破百万,在目标检测领域形成了广泛的学术与工业影响力。

具备丰富的企业级项目交付经验,曾为工业视觉检测、智慧城市安防等多个关键领域提供定制化的算法模型与解决方案,驱动业务智能化升级。

💡 未来方向与使命

秉持 “让每一行代码都有温度” 的技术理念,未来将持续聚焦于实时检测、语义分割及工业缺陷检测的商业化闭环等核心方向。愿与业界同仁协同创新,共同推动技术边界,以坚实的技术能力赋能实体经济与行业变革。

原创自研系列, 25年计算机视觉顶会创新点

《YOLOv13魔术师》

《YOLOv12魔术师》

《YOLO11魔术师》

《YOLOv8原创自研》

《YOLOv5原创自研》

《YOLOv7原创自研》

《YOLOv9魔术师》

《YOLOv10魔术师》

应用系列篇:

《YOLO小目标检测》

《深度学习工业缺陷检测》

《YOLOv8-Pose关键点检测》

23、24年最火系列,加入24年改进点内涵100+优化改进篇,涨点小能手,助力科研,好评率极高

《YOLOv8魔术师》

《YOLOv7魔术师》

《YOLOv5/YOLOv7魔术师》

《RT-DETR魔术师》

论文:https://link.springer.com/epdf/10.1007/s11554-025-01778-9?sharing_token=rDKMnrQEzCxT2Wr4kWgYnPe4RwlQNchNByi7wbcMAY7i6oMoiQDPk0kNJBwnurt8py7vBvRxkfPjPgkx8TcC-EUH9I8pVeBO017ovrURq3GBAhPeKl4XIxDUYChtFE1Coa6mNp5F3mw7BPb9L29xofEXcPnPGojZpfRwLVDVCVo%3D

摘要:在海洋资源勘探及其他海事活动中,水下目标检测至关重要。尽管YOLO系列模型占据主导地位,但在复杂水下环境中仍面临诸多挑战:被遮挡小目标特征丢失、密集区域特征混淆、严重噪声与光衰减导致的低对比度图像模糊,以及模型轻量化设计不足。针对这些问题,本文提出一种轻量化水下目标检测模型(LUOD-YOLO)。该模型创新性地提出动态局部-全局特征融合注意力机制模块(DLGA),通过多尺度注意力机制与动态双路径融合策略,增强对遮挡小目标的特征提取与检测能力。此外,设计轻量化双路径通道重排模块(DPC),将输入特征图分割处理并通过通道重组进行拼接,有效解决海洋生物重叠区域的特征混淆问题。同时引入基于轻量级CNN的跨尺度特征融合模块(CCFF),提升模型对模糊低对比度图像的识别能力。通过在UOD和DUO数据集上的实验表明:相较于YOLOv8n,LUOD-YOLO在UOD数据集上不仅将mAP50:95提升至54.2%(提高0.2%),且模型参数量与计算量分别降低45.7%和28.4%。

LUOD-YOLO.yaml

nc: 80scales:n: [0.33, 0.25, 1024]# YOLOv8.0n backbonebackbone:- [-1, 1, Conv, [64, 3, 2]]- [-1, 1, DPC, [128]]- [-1, 3, C2f, [128, True]]- [-1, 1, DPC, [256]]- [-1, 6, C2f, [256, True]]- [-1, 1, DPC, [512]]- [-1, 6, C2f, [512, True]]- [-1, 1, DPC, [1024]]- [-1, 3, C2f, [1024, True]]- [-1, 1, SPPF, [1024, 5]]# YOLOv8.0n headhead:- [-1, 1, Conv, [256, 1, 1]]- [-1, 1, nn.Upsample, [None, 2, 'nearest']]- [6, 1, Conv, [256, 1, 1, None, 1, 1, False]]- [[-2, -1], 1, Concat, [1]]- [-1, 3, DLGA, [256]]- [-1, 1, Conv, [256, 1, 1]]- [-1, 1, nn.Upsample, [None, 2, 'nearest']]- [4, 1, Conv, [256, 1, 1, None, 1, 1, False]]- [[-2, -1], 1, Concat, [1]]- [-1, 3, DLGA, [256]]# 替换下采样层- [-1, 1, DPC, [256]]- [[-1, 15], 1, Concat, [1]]- [-1, 3, DLGA, [256]]# 继续下采样- [-1, 1, DPC, [256]]- [[-1, 10], 1, Concat, [1]]- [-1, 3, DLGA, [256]]- [[19, 22, 25], 1, Detect, [nc]]

作为全球资源的重要组成部分,海洋资源正日益凸显其重要性,人类对海洋的探索与开发步伐正逐渐加快。在此背景下,高效的水下目标检测技术已成为不可或缺的关键环节。

依赖潜水员的传统水下探测方法存在诸多局限性。该方法仅适用于浅水区域,而潜水员在深水作业时需面临巨大的生理和安全风险。此外,其检测效率较低,潜水员还易受到减压病、溺水及海洋生物威胁等问题困扰。这些因素使得传统方法难以满足大规模海洋勘探的需求。

随着计算机视觉技术(如AVLTrack[1]、SmallTrack[2]、CRM[3]、BFF[4]等)的快速发展,人工检测手段正逐渐被智能方法取代。尽管基于传统计算机视觉的方法[5,6]已得到广泛应用,但在应对大量复杂多变的水下环境图像高效检测任务时,这些方法仍存在一定局限。基于深度学习的目标检测模型(以YOLO系列为代表)凭借其优异的实时推理性能和强大的端到端处理能力,已成为目标检测领域的主流方法之一[7-9]。虽然YOLO系列模型在通用目标检测任务中取得了一定成果,但在水下目标检测这一特定领域仍存在明显局限性。

目前基于YOLO系列模型的主流优化方法主要分为三类:

(1)基于注意力机制的增强方法,如CEH-YOLO[10]、YOLO-UOD[11],或组合应用现有注意力机制(如SE[12]、CBAM[13]、GAM[14]、ECA[15]等)的UTD-Yolov5[16]、YOLOv7-AC[17]。这些方法在一定程度上缓解了小目标特征提取不足和局部信息丢失等问题,但在遮挡目标特征提取能力方面存在局限,且模型泛化能力有待提升。

(2)采用数据增强与去噪技术的优化方法,如SU-YOLO[18]、YOLO-Vortex[19]等。虽然这些方法增强了水下目标检测的鲁棒性,但模型计算复杂度较高,小目标特征提取能力有限。例如YOLO-Vortex通过涡旋机制抑制无关噪声时,可能误将小目标本身特征识别为噪声而丢失,尤其在生物纹理特征与环境高度相似时更为明显。

(3)卷积改进方法:如DP-YOLO[20]通过结合可变形卷积提升识别精度,但易受环境噪声干扰,且未能解决目标堆叠导致的特征混淆问题。

综上所述,水下目标检测特定任务主要面临四大挑战:

(1)复杂多变的水下环境使小型海洋生物更易隐匿,导致特征丢失;

(2)部分海洋生物具有群居习性,常呈密集堆叠分布,易导致个体间特征混淆,模型难以准确识别定位每个个体,进一步增加检测难度;

(3)水下悬浮物与波纹噪声对图像产生影响,加之水下光衰减严重(尤其在深水区域),导致图像整体昏暗、对比度低,目标与背景边界模糊;

(4)现有方法多在提升检测精度的同时增加了计算复杂度与模型体积,难以在设备上高效运行。

考虑到水下目标识别中的算力限制,本研究将轻量化设计[21-24]作为首要目标。在实现轻量化设计的基础上,我们针对遮挡小目标特征丢失、密集区域特征混淆、严重噪声与光衰减导致的模糊低对比度图像[25]三大核心问题提出解决方案,以最大限度补偿性能损失,实现模型轻量化与检测性能的平衡。

基于此,本文以YOLOv8n目标检测模型为基线进行改进,提出LUOD-YOLO模型。具体而言:DLGA模块通过动态局部-全局特征融合注意力机制,显著提升模型对缺失特征的提取能力;DPC模块通过双路径通道重排,解决密集堆叠区域的特征混淆问题;此外,LUOD-YOLO还在YOLOv8n[27]结构中复用了RT-DETR[26]提出的轻量级CCFF模块。当面临图像模糊、光照不均及复杂背景干扰等挑战时,该模块能提升目标定位与分类的鲁棒性。

本研究的核心贡献如下:

• DLGA能更好结合全局上下文信息,高效压缩提取语义特征,在不增加计算量的前提下增强模型对多尺度目标的感知能力,尤其在面对遮挡小目标等复杂场景时,进一步提升了模型检测能力;

• DPC使模型能更灵活利用全局信息,增强重叠区域表征多样性,精准捕捉个体特征,避免堆叠区域的个体特征混淆问题,同时采用轻量化设计降低模型计算复杂度;

• 本研究在大型多样化海洋生物数据集上进行了广泛测试,实验结果表明该方法在所提出问题的不同场景中均具有优越性,凸显出模型的强大泛化能力。

后续内容安排如下:第2节回顾现有方法,总结其优势与局限,明确研究突破点;第3节详细阐述LUOD-YOLO模型架构,解析三个模块的设计原理与工作机制;第4节介绍数据集、实验环境与评估指标;第5节展示并分析关键实验结果;第6节总结研究成果,讨论模型局限性并展望未来研究方向。

本节回顾基于YOLO的水下目标检测任务及相关领域的三类主流优化方法。通过借鉴这些方法的经验并分析模型局限性,探索突破方向,为本研究奠定基础。

2.1 基于注意力机制的改进

CEH-YOLO[10]通过HDA模块精确定位水下目标关键区域,动态调整特征权重以突出重要特征,并借助ESPPF模块融合多尺度特征来增强提取能力。其CD模块集成辅助检测与分类信息以提升精度,但在高密度区域识别中表现不佳,易将该区域生物误判为单个实体。YOLO-UOD[11]基于YOLOv4-tiny,采用对称瓶颈结构和FPN-Attention模块融合深浅层特征,结合标签平滑策略提升抗干扰能力,从而提高了检测效率。然而尽管计算速度有所提升,其泛化能力仍显不足。UTD-YOLOv5[16]将YOLOv5主干网络替换为CSP2,逐层提取多尺度特征,并引入SE模块学习关键特征通道以增强表达能力,但在处理大规模数据集时易受限。YOLOv7-AC[17]通过组合ACmixBlock、ResNet-ACmix和GAM全面捕捉特征信息。然而介质散射与吸收导致的色彩失真和低可见度会使目标特征模糊,引发误检漏检。

2.2 基于数据增强与去噪技术的改进

Younes Ouassine等[28]利用数据增强与预处理改进YOLOv5的珊瑚礁识别,但该方法专用于珊瑚礁,对高浓度珊瑚图像可能受限。常路宁等提出YOLO-Vortex[19],通过涡旋聚合网络模块、损失函数优化及空间注意力集成来增强对关键特征的关注并抑制噪声,在特征提取与噪声抑制方面表现优异。然而在抑制无关噪声时,可能误将小目标特征识别为噪声,且复杂度增加导致在资源受限的水下环境中实时性较差。陈龙等提出SWIPENET与IMA算法[29],利用高分辨率特征图和样本重加权有效提升小目标检测精度并降低噪声影响。但作为M个深度神经网络的集成模型,其仍保持高计算复杂度且易过拟合。针对模型计算速度,李晨阳等提出SU-YOLO[18],基于轻量级脉冲神经网络(SNN),通过去噪模块和优化归一化提升检测精度。然而其能效优势目前仅依赖理论估计,缺乏实际硬件测试数据支撑。

2.3 基于卷积方法的改进

王H.等[30]提出改进版YOLOXs用于水下生物检测,采用GhostConv与GhostBottleneck实现模型轻量化以适配水下设备的存储与计算限制,并引入上下文Transformer模块增强特征表征。尽管检测精度与适应性有所提升,但复杂模块降低了FPS,在极端环境下性能有限。Yuan等[20]通过DP-YOLO与动态检测门算法实现金枪鱼自动计数:可变形卷积与部分卷积显著增强特征提取与计算效率,而动态检测门解决遮挡与重复计数问题。但该方法在夜间及恶劣天气条件下进行识别时,因图像模糊、对比度低会导致识别能力下降。

尽管当前水下目标检测方法在特征提取融合、关键区域定位等方面有所改进,但在处理高密度目标区域或低质图像时检测精度显著降低。此外,模型高复杂度与大计算量导致在资源受限设备上处理大规模数据集时实时性存在明显局限。相较而言,LUOD-YOLO中的DLGA在不增加计算量的前提下有效增强多尺度目标感知,提升了对遮挡小目标的检测能力;DPC采用轻量化设计,帮助模型灵活利用全局信息,避免重叠区域的特征混淆;CCFF通过通道压缩与结构简化降低计算复杂度,有效抑制噪声,进一步增强了模型的鲁棒性与泛化能力。

本章节将详细阐述所提出的模型。首先介绍LUOD-YOLO海洋生物目标检测模型的整体架构,随后分别解析本文设计的两个轻量化模块(DLGA、DPC与CCFF)的功能原理。

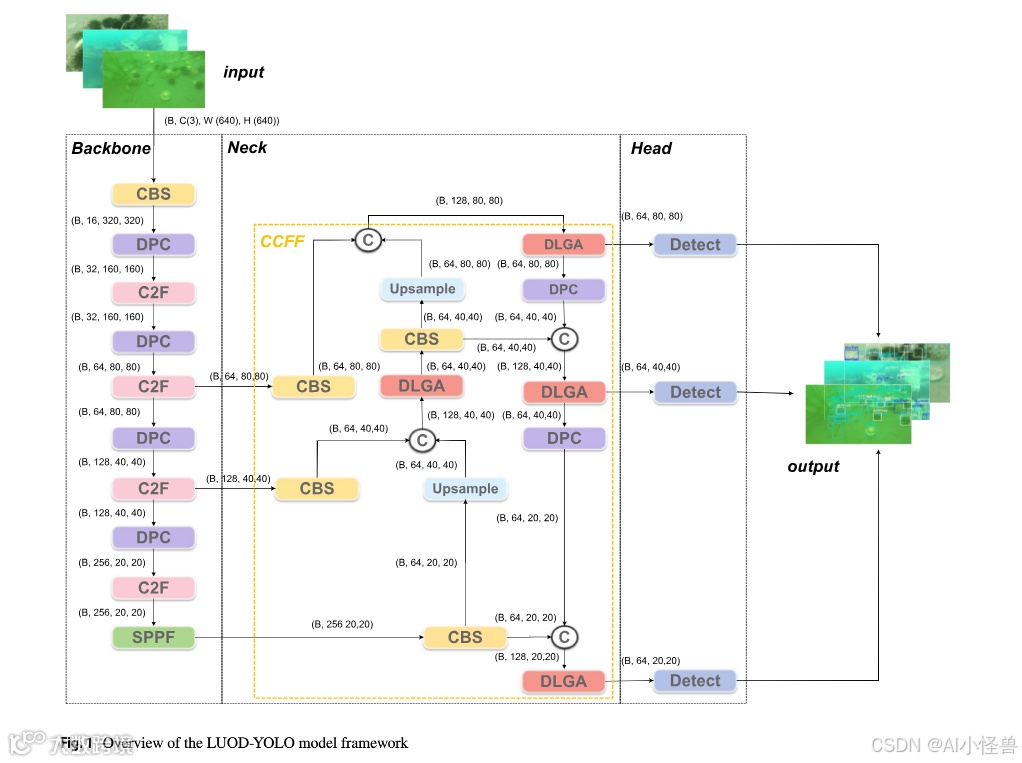

3.1 模型概述

如图1所示,以YOLOv8n为基线算法改进的LUOD-YOLO采用主干-颈部-头部(backbone-neck-head)架构。本研究选择YOLOv8n作为主要改进基线基于以下关键原因:(1)本研究旨在提升水下目标检测速度,因此选择轻量级YOLO Nano(n)系列作为起点;(2)YOLOv8在各种目标检测任务中通常能更好地平衡精确率与召回率,获得更稳定的F1分数,从而降低误检与漏检率;(3)YOLOv8n结构清晰、易于使用、泛化能力强,在YOLO系列中广受认可,以其为基线便于读者复现与进一步研究。

具体而言,在主干-颈部-头部架构中:

主干网络通过堆叠C2F模块与本文提出的DPC模块进行多尺度特征提取与压缩。其中DPC模块通过双路径通道重排技术,增强模型在识别目标密集堆叠区域时对不同层次信息的理解能力。

颈部网络融合浅层特征与深层特征。该部分采用CCFF架构,通过跨尺度特征融合增强模型对不同尺度信息的理解能力,并能有效抑制噪声干扰。

本文提出的DLGA模块通过灵活运用全局与局部信息,增强模型对信息缺失目标的特征提取能力。

检测头融合颈部网络输出的特征,最终输出预测目标边界框的位置信息。

3.2 动态局部-全局特征融合注意力机制模块(DLGA)

DLGA模块旨在解决被遮挡小目标特征丢失的挑战。其通过特征精炼模块的局部-全局双路径动态融合全局上下文机制,增强模型提取被遮挡小目标关键特征的能力。该模块结构如图2所示。

首先,DLGA通过卷积将输入特征拆分为两条并行分支:

随后,特征f1进入恒等分支,通过跳跃连接保留原始空间通道信息;同时f2进入主分支,经过n个堆叠的特征精炼槽模块进行迭代优化。在主分支中,首个特征精炼模块将原始输入特征f2与经过两次序列卷积及动态局部-全局特征融合模块处理后的特征相结合,得到f(0)out。随后将f(0)out输入下一特征精炼模块,迭代重复此过程获得frefined:当n=1时仅使用单一特征精炼模块,此时frefined等于f(0)out;当n>1时,frefined对应递归依赖的f(i)refined。

实验中设定n=1以实现轻量化模型,使其适用于移动设备与实时推理场景。n每增加1,模型参数量约增加0.8M,GFLOPs约上升0.4。这是因为每次迭代都涉及特征图的非线性变换与注意力机制增强。当计算资源充足时,n可设置为大于3的值,但需注意避免n过大导致的过拟合与梯度消失问题。

最后,将f1与frefined进行拼接,并通过1×1卷积压缩生成最终输出Fout。

DLG模块作为DLGA的核心组件,采用双分支架构动态整合局部与全局上下文特征。给定输入特征图X,首先通过自适应平均池化将空间维度压缩至L×L获得局部特征Flocal。

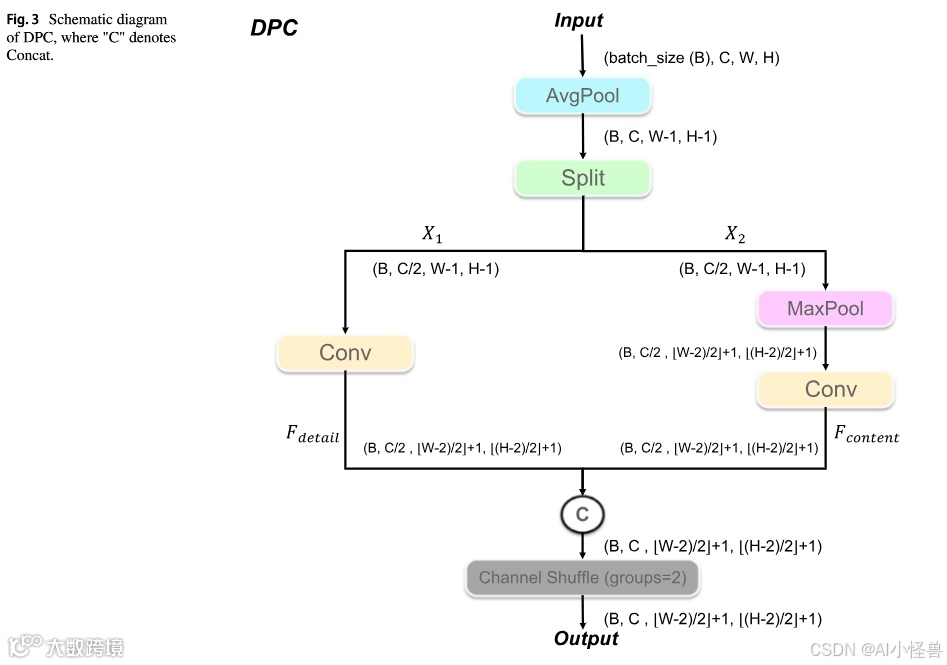

3.3 双路径通道重排模块(DPC)

为解决海洋生物重叠区域特征提取困难与易混淆的问题并降低模型复杂度,本研究提出DPC模块。该模块主要在下采样阶段(主干与颈部网络中)替代传统卷积,通过灵活运用全局特征同时增强模型对局部细节的特征提取能力,从而有效提升模型对海洋生物重叠区域的判别能力,实现更精准的特征区分。模块结构如图3所示,具体流程如下:

输入特征X首先通过平均池化下采样获得X′:

随后将特征X′沿通道维度拆分为两个子特征图。

3.4 基于CNN的跨尺度特征融合模块(CCFF)

如图4所示,目标检测任务中特征...(此处原文不完整)。YOLOv8n与CCFF存在结构相似性:RepBlock与上采样均承担特征融合功能。同时RT-DETR中CCFF模块的跨尺度特征融合理念与YOLOv8融合多尺度特征的方法相符,使得将CCFF集成至YOLOv8n具有可行性。仅需在特征接触前添加1×1卷积(如图中箭头所示)。引入CCFF后的改进主要体现在三方面:

首先,在检测头前端引入通道对齐卷积,将多尺度特征统一压缩至相同通道数,避免因维度差异导致的特征融合不足,从而增强模型捕捉细节与利用语义信息的能力,同时显著降低跨层融合的计算复杂度。

其次,在特征投影层前植入无偏置的横向补偿卷积,通过跨阶段跳跃连接建立双向特征补偿路径。该设计能动态加权浅层高频细节与深层语义抽象之间的跨层交互,使网络同时增强小目标纹理特征并抑制悬浮物噪声。具体而言,当浅层特征通过补偿卷积注入深层时携带定位细节;当深层特征反向补偿浅层时则提供语义筛选能力。这种双向交互机制进一步提升了模型在模糊图像与复杂背景下的鲁棒性。

最后,通过用跨层下采样连接替代传统渐进式连接,重构特征金字塔融合路径,形成适用于P3、P4、P5跨尺度特征的网状融合拓扑。这使得任意层级特征可直接交互,突破传统链式结构的单路径信息流限制,以及逐层传递导致的特征信息稀释。因此,在光照不均情况下,模型能通过底层特征保持暗区物体的可识别性,同时利用高层特征抑制过曝区域的伪影干扰。

4.1 数据集

本研究采用两个数据集(UOD数据集[31]和DUO数据集[32])。所有数据集在训练前均经过预处理并剔除了脏数据以优化数据质量。UOD数据集标注了海参、海胆和扇贝三类海洋生物,包含超过2500张水下海洋生物图像用于模型训练。DUO数据集则标注了海参、海胆、扇贝和海星四类海洋生物,训练集包含超过6600张图像。 comparative experiments were carried out on the UOD and DUO datasets, and UOD was also utilized for ablation experiments. 上述两个数据集测试集中的数据具有海洋生物密集堆积、图像模糊、低对比度等特点,很好地代表了我们所提出的问题。

4.2 实验环境

所有实验均在Windows 11系统、NVIDIA RTX 4090D 24GB GPU环境下进行,使用PyTorch (CUDA 11.8)、Python 3.10和Jupyter Notebook。为公平比较,所有模型均在相同数据集和相同设置下训练。输入分辨率固定为640×640,优化器为随机梯度下降(SGD),损失函数为CIoU和二元交叉熵(BCE)的组合。未使用任何数据增强以消除随机性影响。对于较小的UOD数据集,模型训练150个周期,批量大小为32;对于较大的DUO数据集,批量大小设为16,训练100个周期。测试时所有模型均使用默认参数,未进行额外调优。

4.3 评估指标

本研究采用五个关键指标综合评估检测模型性能:精确率(P)、召回率(R)、F1分数(F1)、平均精度均值(mAP50, mAP50:95)。同时,使用模型参数量(Params)、十亿次浮点运算次数(GFLOPs)和模型大小(Size)衡量模型的轻量化性能,使用延迟(Latency)、帧率(FPS)和峰值GPU内存(PGM)评估模型的实时推理能力。

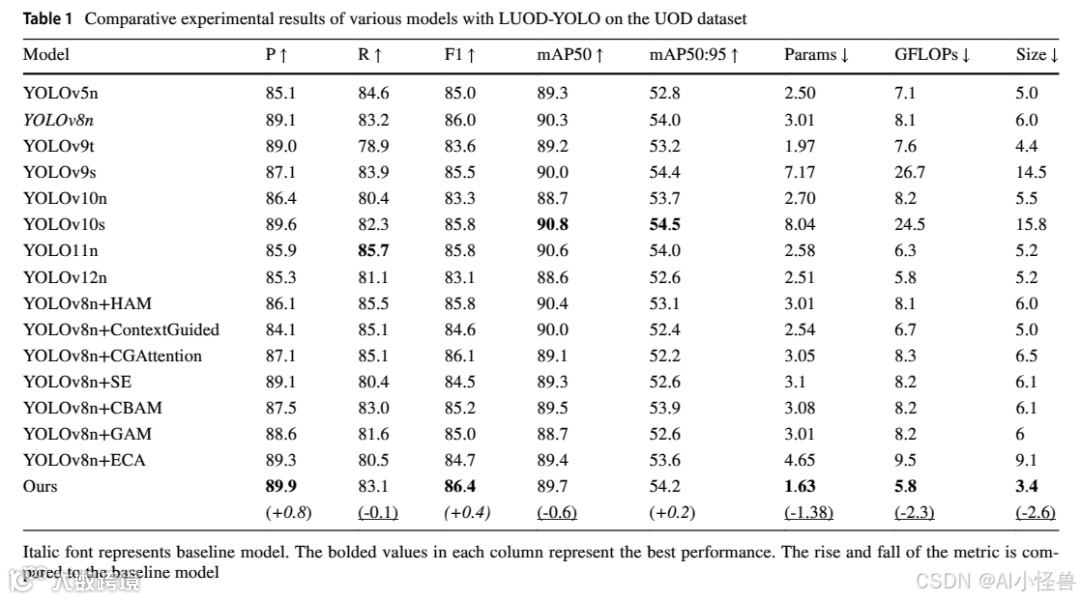

为验证LUOD-YOLO模型在水下目标检测中的有效性,本研究设计了一系列实验。首先展示了模型在UOD数据集上训练过程中各项指标及损失函数的变化情况。随后,在UOD和DUO数据集上,使用11项关键指标将LUOD-YOLO与一系列YOLO目标检测模型进行了全面对比评估,这些模型包括YOLOv5n、YOLOv8n、YOLOv9t、YOLOv9s、YOLOv10n、YOLOv10s、YOLO11n、YOLOv12n [27, 33–37]以及YOLOv8n的变体(如YOLOv8n+HAM [38]、YOLOv8n+CGAttention [39]、YOLOv8n+ContextGuided [40]等)。

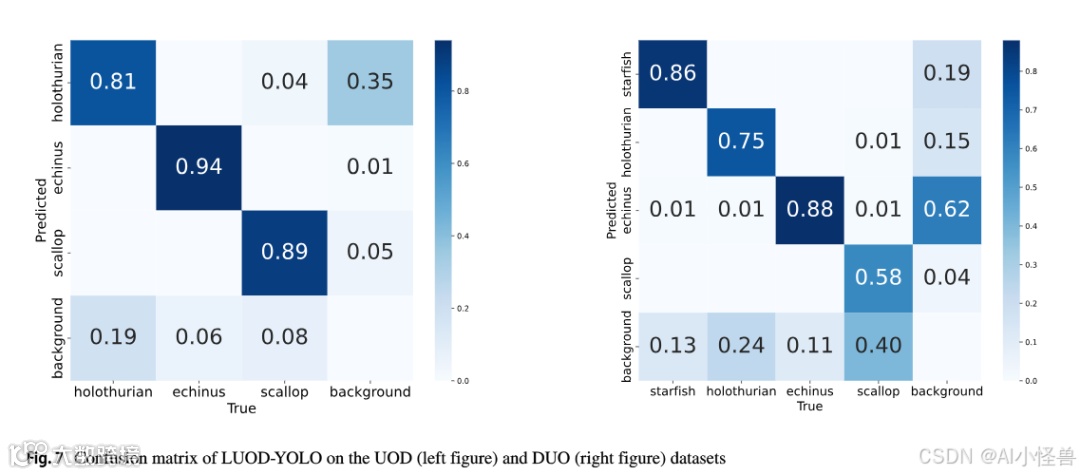

此外,利用精确率-召回率曲线(P-R Curve)和混淆矩阵直观展示了LUOD-YOLO对不同海洋生物的分类性能,识别了模型在不同类别上的优势与待改进之处。为进一步研究,从DUO数据集中选取了五个具有代表性的复杂场景,直观展示了不同模型在水下目标检测中检测结果的差异。同时,开展了消融实验以验证关键模块(DLGA、DPC、CCFF)的结构有效性及其对模型整体性能的具体贡献。最后,分析了模型的局限性。

5.1 模型训练过程

图5展示了模型在训练集和验证集上的损失及性能指标变化情况,包括边界框损失、分类损失、Focal Loss(DFL Loss)、精确率、召回率以及mAP50 & mAP50:95。如图所示,模型初始损失值较高但收敛迅速,性能指标快速上升,表明学习效率较高。随着迭代次数增加,曲线变化速率放缓,显示模型逐渐收敛。曲线在大约30次迭代后趋于稳定,并在150次迭代时保持稳定。

5.2 UOD数据集对比实验

为评估模型性能,在P、R、F1、mAP50、mAP50:95、Params、GFLOPs和Size指标上将LUOD-YOLO与其他YOLO系列模型进行了比较,结果如表1所示。LUOD-YOLO取得了最高的P和F1。其89.9%的P值反映了较低的误检率和可靠的结果,这归功于DPC有效利用全局信息,即使在目标重叠情况下也能实现准确分类。86.4%的F1值显示了良好的P-R平衡和卓越的综合性能,这得益于DLGA强大的多尺度特征感知和全局信息整合能力,增强了复杂场景下的鲁棒性。此外,R、mAP50和mAP50:95分别为83.1%、89.7%和54.2%。mAP50:95略低于YOLOv9s和YOLOv10s(分别低0.2%和0.3%)。Params为1.6M,GFLOPs为5.8G,Size为3.4MB,均是对比模型中的最低值。Params是YOLOv8n的53.3%,GFLOPs和Size分别比YOLOv8n+HAM低0.9G和1.6MB。这些结果表明该模型在保持高精度的同时提升了计算速度。

相比之下,LUOD-YOLO在所有指标上均优于集成其他注意力机制(SE、CBAM、GAM、ECA)的YOLO变体。SE通过全局平均池化捕捉通道注意力,ECA则建模通道关系。然而,两者在捕捉局部空间细节方面不足,限制了其提取被遮挡小目标特征的能力。此外,ECA显著增加了模型复杂度和计算成本。CBAM虽然集成了通道和空间注意力,但其通过单尺度卷积生成空间注意力,不足以处理不同尺度的目标,尤其是密集排列的小目标。GAM尽管具有全局上下文建模能力,但在抗噪声方面表现不佳。

相比之下,DLGA通过自适应池化将特征压缩到局部和全局路径,并动态学习其权重。这使其能够在复杂场景中清晰区分目标的局部细节和全局语义信息,从而有效提取关键目标特征。同时,DPC进一步增强了模型对全局信息的利用能力,CCFF则赋予了模型更高的鲁棒性。

5.3 DUO数据集对比实验

在DUO数据集上的进一步验证涉及将LUOD-YOLO与其他模型在P、R、F1、mAP50和mAP50:95上进行比较,结果亦见表2。LUOD-YOLO表现突出,F1达到77.9%,仅次于复杂模型YOLOv9s和YOLOv10s。它分别优于YOLOv10n、YOLOv12n和YOLOv8n+ContextGuided达2.1%、2.2%和3.1%,显示了在模糊和噪声等挑战性条件下可靠识别海洋物种的能力。P和R分别为83.9%和72.7%,P分别超过YOLOv9t、YOLOv10n、YOLO11n和YOLOv8n+ContextGuided达2.2%、2.0%、1.9%和5.2%。mAP50和mAP50:95分别为80.8%和60%,表明在不同IoU阈值下均具有高精度检测能力。

尽管LUOD-YOLO的两项mAP值均略低于基线模型YOLOv8n,但下降幅度均未超过1%。这表明通过在小目标特征提取和特征分类等方面的改进,模型已尽可能减小了因显著轻量化带来的性能下降。同时,LUOD-YOLO的P、R和F1均优于基线模型YOLOv8n。更高的P意味着LUOD-YOLO相比YOLOv8n误检更少,这在解决特征混淆问题上取得了突破。更高的R则证明LUOD-YOLO能有效捕捉被遮挡小目标的特征,并在模糊、低对比度的水下图像中有效抵抗干扰,从而实现更低的漏检率。

5.4 精确率-召回率曲线

图6展示了LUOD-YOLO模型在两个数据集上识别各类别海洋生物的P-R曲线。

在UOD数据集上,模型在海胆和扇贝的识别上表现尤为突出,识别率分别达到95.8%和91.6%。尽管对海参的识别效果稍弱,但仍达到81.7%。在DUO数据集上,模型对海星和海胆的精确率均超过90%,但对扇贝的识别精确率相对较低,仅为62.4%,尚有较大提升空间。总体而言,模型在两个数据集上所有类别的平均mAP50分别达到89.7%和80.8%,显示出优异的整体性能。

5.5 混淆矩阵

如图7所示,混淆矩阵展示了模型在UOD和DUO数据集上的分类性能。在UOD数据集上,LUOD-YOLO在识别三种海洋物种方面表现优异:海胆(94%)、扇贝(89%)和海参(81%)。部分海参被误分类为背景,但性能仍然强劲。在DUO数据集上,模型在海胆(88%)和海星(86%)上表现良好,但扇贝的检测率较低(58%),且许多被误分类为背景,这可能源于扇贝附着沙粒以及其纹理与石头相似。背景也被误分类,表明在扇贝检测和背景区分方面还有改进空间。

5.6 复杂场景可视化

为了比较不同模型在水下目标检测中的性能,我们从DUO数据集中选取了五个复杂场景:黑暗环境、密集堆叠、模糊、广角以及颜色与周围环境融合且堆叠的场景。如图8所示,YOLOv5n对扇贝的漏检率很高,尤其是在物体密集堆叠的场景中。这表明YOLOv5n在处理密集小尺寸物体时,由于特征提取和融合不够精细,难以有效区分相邻物体的边界和细节。

相比之下,YOLOv8n提高了检测精度,对扇贝的召回率更高。但在广角条件下会误检海星。此外,在密集堆叠场景中,它经常将单个海参误检为多个,并将一些背景误分类为海洋生物,表明其特征判别能力有待进一步提高。YOLOv9t在黑暗环境中对海胆的识别有所改善,能够更好地识别利用颜色伪装隐藏在黑暗背景中的海胆。然而,它对海星存在一定的漏检率。尽管其识别具有特定颜色伪装的物体的性能有所提高,但对海星等形状或纹理复杂的物体的特征提取能力仍有待加强。

YOLOv10n在各种场景下识别海胆的准确率超过90%,但在模糊或密集堆叠场景中对扇贝的漏检明显。此外,在远距离识别时可能将背景区域误检为海星。这可能源于其无NMS的设计,该设计依赖一对一角点预测,在高度重叠场景中可能导致漏检或定位漂移。

YOLO11n和YOLOv12n在黑暗环境中对海胆都表现出高召回率。然而,YOLO11n在模糊场景中对海胆存在一定的误检问题,可能因为它倾向于在低信噪比图像中对噪声纹理过拟合。此外,两种模型在远距离识别时都将大部分背景区域误检为海星,这可能是过度剪枝降低了它们识别小目标的能力所致。

YOLOv8n+HAM在密集场景中对海参的检测较好,但在远距离检测中表现较弱。YOLOv8n+ContextGuided和YOLOv8n+CGAttention在密集场景中对海参的误检率较高,且在远距离检测中性能不佳。

相比之下,LUOD-YOLO展现出卓越的整体性能。在黑暗、模糊场景中,它能有效抑制噪声,实现对多种生物的高精度识别。在密集堆叠物体场景中,它能准确分类海洋生物,这得益于其在重叠区域灵活运用全局信息。此外,它在远距离识别方面表现优异:对海星无误检/漏检,仅对海胆有少量漏检。

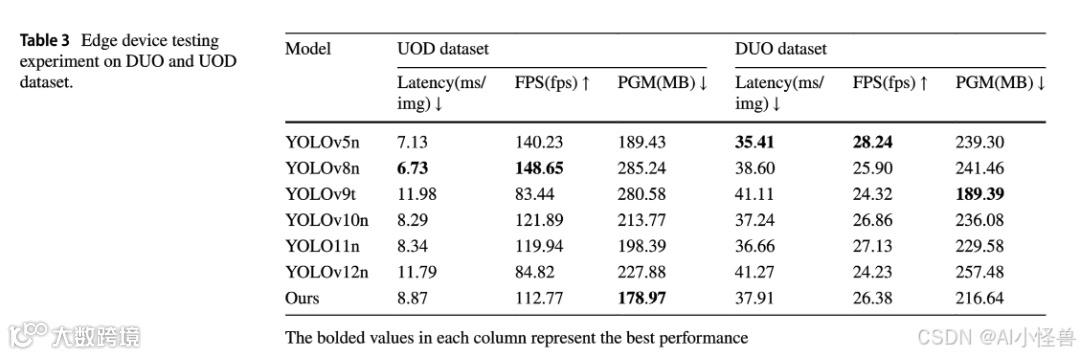

5.7 推理性能评估实验

在实验设置方面,硬件配置包括1个32GB vGPU(支持容量扩展)、16个基于AMD EPYC 9654 96核处理器的vCPU、60GB内存和30GB系统盘。所有模型均使用DUO和UOD数据集的测试集进行测试,测试过程中对所有模型进行了10帧的热身。实验在两个数据集上测试了模型的三个指标:延迟(Latency)、帧率(FPS)、峰值GPU内存(PGM)。如表3所示,可见模型在两个数据集上的综合性能表现优异。具体来说,在UOD数据集上,LUOD-YOLO的PGM是所有模型中最佳的,仅为178.97。这表明该模型可以直接部署到内存较小的设备上,无需额外的剪枝操作。同时,凭借其极低的内存占用,可以实现多实例并行部署,从而显著提高GPU资源利用率和并发吞吐能力。在DUO数据集上,模型的PGM为216.64,仅略高于YOLOv9t。然而,YOLOv9t的延迟达到41.11,其FPS仅为24.32,在所有模型中处于较低水平。相比之下,LUOD-YOLO的延迟仅为37.91,其FPS高达26.38,这进一步证明了LUOD-YOLO在资源受限设备上的高效运行能力。

5.8 消融实验

为验证DLGA、DPC和CCFF模块的有效性,以YOLOv8n为基线在UOD数据集上进行了消融研究。如表4所示,YOLOv8n初始的R和mAP50分别为83.2%和90.3%。仅添加DLGA略微降低了P,但将R提升至86.7%(+3.5%),F1提升至87.4%,为模型中最佳,证明了DLGA带来的显著性能提升。mAP50也升至91.2%。仅添加DPC将P提升至90.6%但降低了R,同时Params、GFLOPs和Size下降。仅添加CCFF获得了与YOLOv8n相近的性能,但模型复杂度显著降低(Params 1.97M,为YOLOv8n的65.7%)。当结合DLGA和DPC时,P提升至89.6%;DLGA和CCFF结合进一步将P提升至89.5%。同时添加DPC和CCFF实现了90.2%的P,且复杂度降低。

当集成全部三个模块时,LUOD-YOLO达到了最优性能:P、F1和mAP50:95均超越YOLOv8n,分别达到89.9%、86.4%和54.2%。模型复杂度被显著最小化:Params从3.0M减少到1.63M(降低45.7%),GFLOPs从8.1G减少到5.8G(降低28.4%),Size从6.0MB减少到3.4MB(降低43.3%)。这证实了DLGA、DPC和CCFF对于LUOD-YOLO的性能至关重要,它们共同实现了噪声抑制和高效特征提取,从而实现了高精度和更快速的检测。

5.9 实验局限性分析

尽管LUOD-YOLO在水下生物检测中表现良好,但仍存在局限性。混淆矩阵显示扇贝检测率低于其他类别,这源于沙粒附着及其纹理与石头的相似性,表明在低对比度分类方面仍有改进空间。在DUO数据集的可视化结果中,尽管在模糊和光照不均场景下能有效抑制噪声,但在黑暗、高度模糊的场景(例如黑色海胆)以及对于远处、低分辨率的小型动物仍出现了一些漏检。

本文针对水下生物识别任务提出了轻量化的LUOD-YOLO模型。现有基于YOLO的水下识别模型面临被遮挡小目标特征丢失、特征混淆、模糊低对比度图像以及轻量化设计不足等挑战。LUOD-YOLO集成了提出的注意力模块DLGA、轻量卷积模块DPC,并将CCFF架构嵌入YOLOv8n,以应对特征丢失、混淆、图像模糊/低对比度以及轻量化挑战。实验表明,其在UOD和DUO数据集上分别达到了86.4%和77.9%的F1分数,均比基准模型YOLOv8n高出0.4%。同时,与YOLOv8n相比,模型的Params、GFLOPs和Size分别降低了约45.7%、28.4%和43.3%。这表明LUOD-YOLO在检测精度和轻量化设计之间取得了良好平衡,使其能够在复杂水下环境中准确识别海洋生物,并在实际应用中高效运行于设备之上。

尽管LUOD-YOLO模型取得了良好性能,但当物体处于极度黑暗和模糊场景且目标特征与周围环境高度相似时,它仍存在一定局限性。未来的研究将侧重于通过多模态技术[41]将声纳和红外传感器数据与现有视觉数据相融合,同时扩展数据集。这些努力旨在提高模型识别低对比度物体的能力,并增强其在复杂环境中的鲁棒性。此外,我们将进一步优化模型的损失函数,通过约束预测边界框的面积来增强模型的目标定位能力,从而提高模型的mAP。