强大的Mistral

https://chat.mistral.ai/

Prompt:a running dog

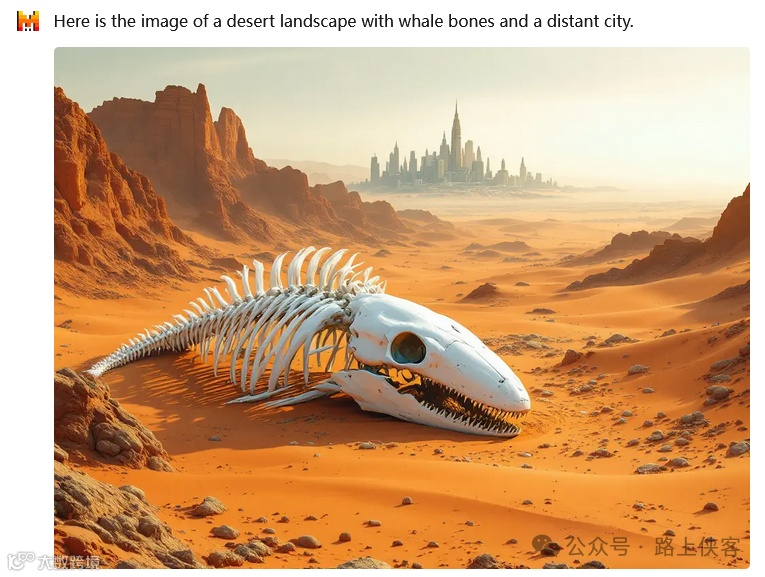

Prompt: a desert landscape with whale bones and a distant city

中英提示词都没有问题,画面精致细腻,但是值得注意的是目前Mistral不支持较为复杂的提示词,也不能在图片上添加文字。

对于创建Agent智能体,我们需要订阅付费。

我们对一个网址进行内容提炼。

https://www.marketwatch.com/story/why-nvidias-championship-season-has-all-the-makings-of-an-ai-dynasty-d8919955

要求进行中文的输出,提示词:“上述需要中文输出“。

整个操作下来还是非常流畅的。

编程和代码输出。

提示词:“使用HTML,CSS和react组件给我设计一个贪食蛇的游戏,需要HTML输出。”

由于代码过长,这边只截取了部分代码,我们来看下效果。

补充知识:

Mistral AI概述

Mistral AI是一家于2023年4月成立的法国公司,在人工智能领域展现出了强大的实力与潜力。其核心产品是大型自然语言处理模型,这一模型借助深度学习技术构建而成,能够对自然语言进行理解与生成,是一种人工智能系统。

近年来,这类大型自然语言处理模型取得了令人瞩目的进步。Mistral AI的最新旗舰模型Mistral Large就是其中的佼佼者,它拥有3.2万tokens的上下文窗口,换算下来能够一次性从接近2.4万个英文单词的文档中精确提取信息。该模型对英语、法语、西班牙语、德语和意大利语有着母语级别的流利程度,并且对语法和文化背景有细致入微的理解,虽然它没有专门针对中文进行优化,但经实际测试,其在中文语境下也是能够使用的。

此外,Mistral AI还推出了对标ChatGPT的对话机器人界面Le Chat,在这个界面中提供了Large、Next和Small三种可选模型。其中Small模型为轻量级模型,Next模型在推理能力上据称是除GPT - 4之外最强悍的。并且Mistral AI也在不断拓展业务,接受了微软的战略投资,从而能够充分利用Azure基础设施等资源 。

Mistral AI的特点和优势

1. 模型性能表现卓越

小模型蕴含大能量:Mistral - 7B是一款精心打造的语言大模型,拥有约73亿参数。尽管参数规模并非巨大,但它在各类基准测试中的表现十分出色。例如,在与当前最佳的开源13B模型——Llama 2对比时,Mistral - 7B力压对手,并且在推理能力、数学计算精准度以及代码生成任务上均超越了已公开的34B模型——Llama 1。这表明Mistral AI在模型优化方面有着独特的技术手段,不单纯依靠大规模的参数来提升性能,在给定的计算预算下,通过合理的模型构建和训练方法,实现了高性能输出。这也从侧面印证了Hoffmann等人的研究,即在给定的计算预算下,最佳性能并不是由最大的模型实现的,而是由更多数据训练的较小模型实现的。据推测,Mistral - 7B的训练数据量可能达到了8T token,相较于Llama 2训练使用的2T token,数据量直接翻了四倍,这或许是其性能优越的原因之一 。

创新架构提升效率:Mistral - 7B的核心技术亮点包括采用分组查询注意力(Grouped - Query Attention, GQA)机制,这一机制显著提升了推理速度。同时,结合滑动窗口注意力(Sliding Window Attention, SWA)策略,使得模型在确保对任意长度输入序列的有效处理的同时,有效降低了推理阶段的资源消耗。另外,Mistral还发布了针对指令理解和执行能力优化的版本——Mistral 7B – Instruct,进一步提升了模型在实际应用中的性能表现。这些技术创新使得Mistral - 7B在处理各种任务时,能够更高效地利用计算资源,快速准确地给出结果,在自然语言处理、代码生成等任务场景中展现出强大的竞争力 。

2. 混合专家(MoE)架构的成功应用

Mixtral 8x7B的高效架构:Mixtral 8x7B是Mistral AI公司的一个重大突破,它采用了名为专家混合(MoE)的架构。这种架构由8个专家组成,每个专家组有7亿参数,总共467亿参数。在实际运算时,每个Token仅需调用两位专家,这样既保证了运算速度,又没有牺牲性能。例如,在处理每个Token时只会用到其中的129亿参数(相当于2个专家),这种精心设计的资源分配优化了处理速度。通过一个网关网络,将输入数据分配给被称为“专家”的特定神经网络组件,这些专家各自擅长处理输入数据的不同方面,这种结构大大提高了模型训练和运算的效率及可扩展性,使得Mixtral 8x7B在多个领域表现出色,如组合任务、数据分析、问题解决还是编程辅助等方面都能展现出优秀的能力。

与其他模型对比的优势:与参数量高达467亿的GPT - 4等大型模型相比,Mixtral 8x7B更小的模型体积展现了Mistral AI对实用性的重视。它在维持高性能的同时,减少了模型的大小和参数,降低了对计算资源的需求,使得在一些资源受限的环境下也能够高效运行。而且,Mixtral 8x7B对法语、德语、西班牙语、意大利语和英语的多语言支持,使其能够满足不同用户的需求,进一步提升了其在多语言处理场景下的优势地位。

3. 灵活的策略与良好的开放性

独特的发布策略:Mistral AI采用了使用torrent分发的非常规发布策略来发布Mixtral 8x7B,这与其他AI产品的精心策划发布形成了鲜明对比,并在AI社区中引发了关于开源模型角色的讨论。这种策略体现了Mistral AI的创新精神和对开源文化的积极探索,虽然这种方式比较独特,但也从侧面反映出公司对自身技术和产品的信心,相信即使通过这种非传统的发布方式,产品也能够得到市场和用户的认可。

开源与宽松许可:Mixtral 8x7B坚持开放性原则,公开了权重数据,允许用户在比起其他公司封闭式AI模型更为宽松的条件下使用它。更进一步,Mistral AI选择了灵活性更强的Apache 2.0许可证来管理Mixtral 8x7B,彰显了它致力于打造一个合作共赢、便捷易用的AI生态系统。这种开源策略有助于吸引更多的开发者参与到模型的改进和应用开发中来,促进技术的快速发展和创新,也使得Mistral AI的模型在众多大语言模型中脱颖而出,受到更多用户和开发者的关注和喜爱。

Mistral AI的应用场景

1. 软件开发领域

代码生成辅助:Mistral AI中的Codestral模型专为代码生成任务而设计,可以帮助开发者编写和与代码交互。例如,在编写Python函数将摄氏度转化为华氏度这样的任务中,Mistral 7B就能够根据提示词生成相应的代码。在软件开发过程中,开发人员经常需要编写各种功能的代码,Mistral AI的模型可以根据开发人员的需求描述快速生成代码框架或者提供代码片段,大大提高开发效率。同时,对于一些复杂的算法逻辑或者函数调用,模型也能够给出合理的建议和示例代码,帮助开发人员更好地理解和实现相关功能 。

程序错误排查:在软件开发中,调试和排查程序错误是一项耗时的工作。Mistral AI的模型可以根据程序报错信息或者异常行为描述,提供可能的错误原因和解决方案。由于模型对多种编程语言有一定的理解能力,它可以分析代码的逻辑结构,找出可能存在问题的代码行或者模块,并给出相应的修改建议。例如,当程序出现运行时错误或者逻辑错误时,将相关的错误信息输入到Mistral AI模型中,它可能会指出是变量类型不匹配、数组越界或者函数调用错误等常见问题,并提供如何修复这些问题的思路。

2. 自然语言处理相关任务

多语言文本处理:Mistral AI的模型支持多种语言,包括英语、法语、意大利语、德语和西班牙语等。在跨国企业、国际交流或者多语言文化环境下,需要对不同语言的文本进行处理,如翻译、摘要、文本分析等任务。以翻译为例,模型可以将一种语言的文本准确地翻译成另一种语言,并且在处理过程中能够考虑到语法、语义和文化背景等因素,生成较为流畅和自然的翻译结果。对于多语言的文档摘要任务,模型可以理解文档的主要内容,提取关键信息并生成相应语言的摘要,方便用户快速获取文档的核心内容。在文本分析方面,无论是情感分析、主题分类还是命名实体识别等任务,Mistral AI的模型都可以应用于多种语言的文本,为跨语言的自然语言处理提供了有力的支持。

问答系统构建:可以利用Mistral AI的模型构建问答系统,用于回答用户提出的各种问题。无论是一般性的知识问答,如历史、科学、文化等方面的问题,还是特定领域的专业问题,如医学、法律、金融等领域的问题,模型都能够根据已有的知识和训练数据进行回答。在构建问答系统时,可以对Mistral AI的模型进行微调,使其更加适应特定领域的问题回答需求。例如,在医疗领域的问答系统中,可以使用大量的医学文献和病例数据对模型进行微调,使模型能够准确回答关于疾病诊断、治疗方法、药物作用等方面的问题。

3. 多模态应用场景

图像理解与文档分析:Pixtral Large是Mistral AI开源的1240亿参数超大多模态模型,具备前沿级图像理解能力,支持128K上下文,能理解文本、图表和图像。在一些需要对图像和文本进行综合分析的场景中,如医学影像诊断报告的解读(影像为图像,诊断报告为文本)、工业设计图纸的审查(图纸为图像,设计说明为文本)等,Pixtral Large可以发挥重要作用。它能够同时处理图像和文本信息,提取其中的关键信息并进行综合分析,为用户提供更全面和准确的结果。例如,在医学影像诊断中,模型可以根据影像中的图像特征以及相关的诊断描述文本,判断疾病的类型、严重程度,并给出相应的治疗建议。

创意内容生成:全新升级后的Le Chat(由Pixtral Large加持)能够支持图像生成、网络搜索、Canvas、PDF上传等强大功能。在创意内容生成方面,用户可以利用Le Chat进行多种创作。例如,在编写故事或者创作文章时,可以借助Le Chat的图像生成功能生成与故事情节相关的图片,或者利用网络搜索功能获取更多的素材和灵感,然后通过Canvas功能进行内容的组织和编辑,最后生成一个包含文字和图像的多媒体作品。对于需要处理大型、复杂的PDF文档和图像,并对其进行分析和总结的任务,Le Chat也能够胜任,它可以提取文档中的关键信息,对内容进行总结概括,并根据用户的需求进行语义理解等操作。

如何使用Mistral AI

1. 创建账户与登录

首先要访问console.mistral.ai 并创建一个免费账户,如果已经有账户则直接登录。这是使用Mistral AI的第一步,通过创建账户,用户可以获得使用Mistral AI相关服务的权限,并且能够对自己的使用设置、偏好等进行管理。登录账户后,用户可以根据自己的需求进一步探索Mistral AI的各种功能和服务。

2. 通过Le Chat界面进行试用

可以使用chat.mistral.ai 上的免费'le Chat'界面来试验Mistral的模型,包括Mistral - large。Le Chat是Mistral对标ChatGPT推出的对话机器人界面,界面清爽。在这个界面中,用户可以打开右上方的下拉菜单,选择使用不同的模型,如Large、Next和Small等模型进行问答测试、文本生成等操作,以体验Mistral AI模型的功能和性能。例如,可以输入一些简单的问题,如编写一段故事、回答某个知识问答等,来感受模型的回答效果和准确性 。

3. 访问La Plateforme获取API和开发工具

登录La Plateforme(console.mistral.ai )以访问Mistral的API和开发工具。这一步对于开发者来说非常重要,通过获取API,开发者可以将Mistral AI的模型集成到自己的应用程序中。例如,在自己开发的移动应用或者网页应用中,调用Mistral AI的模型来实现自然语言处理功能,如智能客服、内容推荐等功能。同时,La Plateforme提供的开发工具可以帮助开发者更方便地进行模型的调用、调试和优化等操作。

4. 获取API密钥并选择模型

在La Plateforme账户设置中生成API密钥以验证API请求。API密钥是保障API调用安全的重要凭证,每个用户的API密钥都是唯一的。在获取API密钥后,选择一个Mistral模型使用,例如mistral - large - latest以获得最先进的功能。不同的模型在性能、功能和适用场景上可能会有所差异,用户可以根据自己的具体需求选择合适的模型进行调用和集成。如果是在本地部署Mistral 7B模型,还可以使用LM Studio等工具。例如,在LM Studio主界面的搜索框搜索Mistral,选择如Dolphin 2.1 Mistral 7B GGUF版本进行下载,下载完成后加载该模型,然后就可以在本地输入问题进行使用。本地部署模型的好处是可以用它作为server,给各种应用提供服务 。

Mistral AI与其他类似产品的比较

1. 与Meta相关模型的比较

架构与性能优化策略差异:Mistral AI是一家总部位于巴黎的欧洲公司,一直在研究如何提高模型性能,同时减少为实际用例部署llm所需的计算资源。Mistral - 7B为传统的Transformer架构带来了Group - Query Attention (GQA)和Sliding Window Attention (SWA)这两个新概念。这些组件加快了推理速度,减少了解码过程中的内存需求,从而实现了更高的吞吐量和处理更长的令牌序列的能力。而Meta的模型可能在架构和优化策略上有所不同,例如Meta可能更侧重于通过其他方式来提升模型性能或者扩大模型规模。在模型性能上,Mistral - 7B在一些基准测试中的表现优于Meta的某些模型,如在与Llama 2对比时,Mistral - 7B展现出了更优秀的推理能力、数学计算精准度以及代码生成能力等。

资源利用效率对比:Mistral AI的模型在资源利用效率方面有其独特之处。例如Mixtral 8x7B采用混合8x7B,通过使用稀疏混合专家 (SMoEs),为每个令牌激活8个可用专家中的2个来减少推理时间,将处理令牌所需的参数数量从47B减少到13B,从而在保证性能的前提下提高了资源利用效率。相比之下,Meta的模型在资源利用方面可能采用不同的策略,可能在某些场景下Mistral AI的模型能够在相同的资源条件下提供更高效的服务或者处理更多的任务。

2. 与GPT系列的比较

模型性能方面:虽然Mistral AI宣称其Mistral Large模型目前除了GPT - 4之外已经超越了其他所有大模型,但在与GPT系列整体对比时,仍然存在差异。例如,GPT - 4在逻辑推理等一些复杂任务上被公认为具有很强的能力,而Mistral AI的模型虽然在某些任务场景下能够表现出与GPT系列相近的性能,但在一些特定的高难度任务中可能还存在一定的差距。不过,Mistral AI的模型在多语言处理、代码生成等方面也有着自己的优势,如Mixtral 8x7B对多种语言有很好的支持并且在代码生成相关的任务场景中能够高效完成任务,而GPT系列在不同版本中对不同功能的优化重点可能有所不同。

商业策略与应用生态:OpenAI的GPT系列在商业推广和应用生态构建方面有其独特之处。GPT系列已经广泛应用于各种商业场景,并且与众多企业建立了合作关系,形成了较为庞大的应用生态。而Mistral AI虽然也在不断拓展业务,接受了微软的战略投资,但在应用生态的构建方面可能还处于发展阶段,与GPT系列相比在市场覆盖范围和商业合作的广度上可能存在一定的差距。不过,Mistral AI的开源策略和灵活的许可方式(如Mixtral 8x7B采用Apache 2.0许可证)为其吸引了很多开发者,在开源社区中逐渐形成了自己的影响力,这也是其与GPT系列在发展模式上的一个不同点。

3. 与Llama系列的比较

模型规模与性能表现:以Mistral - 7B为例,在与Llama 2的对比中,尽管Mistral - 7B的参数量约为73亿,远小于Llama 2的13B,但Mistral - 7B在推理能力、数学计算精准度以及代码生成任务上均超越了Llama 2。这表明Mistral AI在模型构建和优化方面有独特的技术手段,不单纯依靠大规模的参数来提升性能。另外,Mixtral 8x7B在与Llama 2系列对比时,根据公司提供的数据,Mixtral 8X7B优于Llama 2系列。在处理各种任务时,Mixtral 8x7B的MoE架构使其能够更高效地利用资源并展现出优秀的性能表现,而Llama 2系列可能在架构和性能优化上有不同的方向和重点 。

模型的开放性与社区支持:Mistral AI的一些模型(如Mixtral 8x7B)采用了开源策略并且具有开放权重,选择了Apache 2.0许可证,这使得其在开源社区中受到广泛关注和支持。开发者可以根据自己的需求对模型进行改进和优化,并且可以在宽松的许可条件下将其应用于各种场景。

需要更多免费AI工具、最新Ai信息、详细使用和丰富Ai教程、Ai变现方法的小伙伴可以加入路上侠客的知识星球,一年会员,原价199元,现在只需99元。