现在大家都在搞数字化转型,你的数据是不是却还在“慢吞吞”?老感觉使不上劲儿?

根据《中国数据治理白皮书(2023)》的调研来看,现在超过70%的企业都栽过“数据不同步”的坑——要么是数对不上,要么是传得慢,搞得最后要么丢订单,要么错决策。

那今天咱们就借此机会来唠一唠,争取把数据同步和实时集成说透。把数据同步从基础概念到实战策略,再到避坑指南,都给大家讲明白、理清楚。

一、什么是数据同步?

数据同步的本质,是让不同系统里的同一批数据,保持一致。

简单来说,就是你在A系统改了客户手机号,B系统、C系统里的这个手机号,也得跟着变,不能说是A变了,B和C还在那儿呆着呢。

但是真要做起来,这远比“复制粘贴”复杂。

放在以前,很多企业用“定时批处理”就能完成数据同步,每隔一段时间同步一次就行了,这种方式确实对系统的压力小也挺方便,但现在企业的业务节奏快了,这个方式根本不够用,毕竟现在的数据总是实时变化,企业等的时间越长,损失可能就越大。

数据同步的核心价值,就是打破“数据孤岛”,让数据能像活水一样流动起来。

现在大家都知道,企业里面不同部门都有自己的系统,每个系统又都有自己的数据。要是这些数据不同步,麻烦就来了,不同系统的业务人员没对齐颗粒度,你说行他说不行的,就可能会导致对现有数据的认知不清,不同系统之间没法儿有效对接,导致工作效率低下不说,还会流失客源与机会。

实时数据同步的作用主要有三个,少一个都不行:

- 保持一致

- 提高效率

- 支撑决策

但是这里得提醒一句:实时数据也不是同步越快越好,得按实际的业务需求来,不然就会白白浪费资源。

二、实时数据集成的定义

实时数据集成,不是“把同步时间调短”,而是让数据“一直流”——就像水一样,源系统数据一变,目标系统马上就有,中间几乎没延迟。

这种转变不只是技术升级,更是业务思路的变。

以前是“等数据凑够了再处理”,现在是“数据一来就处理”。这可以让不同的业务部门立刻看到数据的变化,从而更好地做出决策、提升效率。

说到实时集成,绕不开三个核心技术,这些技术听起来复杂,其实说清楚以后就很简单。

1.变更数据捕获(CDC)

CDC技术说白了,就是盯着数据库的“日志本”。

每个数据库都有日志,记录谁改了数据、改了什么。CDC不直接查数据库,就看这个日志,数据一有变动,立马就能知道并且把它从源系统给找出来,再传到目标系统。

这种方式有个好处就是不耽误源系统运转。你想啊,要是直接查数据库,数据量大的时候会很卡;看日志就不一样,轻量级,不会说是影响业务的正常进行。

2.消息队列机制

消息队列就像是“数据中转站”。

源系统数据一变,先传到队列里,队列再慢慢发给目标系统。它的好处是“解耦”——源系统和目标系统不用直接对接,就算某一个系统卡了,队列里的数据也不会丢,可以等系统好了再传。

3.数据流处理

流处理就是“数据在传输中就加工”。比如数据从队列里过的时候,顺便就清洗转换了,不用等传到目标系统再处理。

实际用的时候,这三种技术往往一起上:CDC抓数据,消息队列传数据,流处理加工数据。最后出来的就是干净、能用的实时数据。

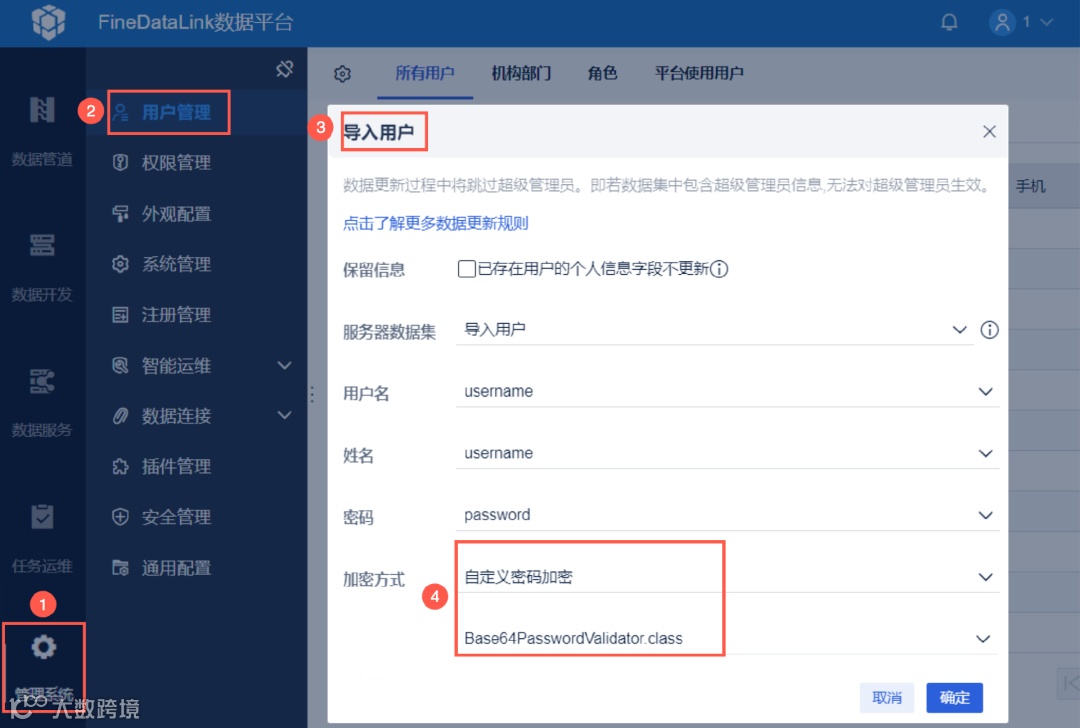

值得一提的是,这些技术现在根本不用你自己搭,像是FineDataLink这种低代码数据集成平台,就把这些复杂技术打包成现成组件。业务人员不用写代码,拖拖拽拽就能配实时同步任务,单表、多表、整库同步都支持,中小企业也能轻松上手。这款工具的体验地址我放在这里,需要自取:https://s.fanruan.com/0dyga(复制到浏览器打开)

三、高效实时数据同步怎样实现?

光懂了技术还不够,得知道怎么落地。主要有三种方法,大家可以参考一下:

1.构建统一的数据接入架构

很多企业一开始会犯一个错:搞“点对点硬连”。

比如CRM连ERP,ERP连WMS,新增一个系统,就得开发好几个接口,这不仅开发的时候耗时间,后面维护起来也会特别费劲。

正确的做法是“分层解耦+适配器模式”:

底层用标准化适配器,不管是MySQL、Kafka还是API,都能接上;中间层搞个统一的“数据路由器”,负责数据转发和转换;上层给业务系统提供标准接口。

2.选择适合的技术

选技术不能跟风,得看自己的需求:

- 要是同步关系型数据库,优先用CDC,实时性高还不影响源系统;

- 要是数据量大、吞吐高,可以用Kafka+流处理,扛得住压力;

- 要是只能通过API拿数据,那就用API轮询,但实时性会差一点。

此外,还有个关键:得保证全链路一致。

比如同步到一半断网了,得知道上次同步到哪了,恢复后接着来,不能从头再来;数据传的时候,得按事务来,要么全传成功,要么全失败,不能传一半。

3.处理多源异构数据

现在企业的数据太杂了,格式不一样,更新频率也不一样,所以核心要做“清洗+映射”,像是对字段的叫法、数据格式这些都得统一起来,不然后面肯定会乱套。

四、挑战与应对措施

其实说实在的,实时同步肯定不是一帆风顺的,总会遇到各种问题。提前知道这些难题,才能少走弯路。

1.数据一致性保障

你是不是也担心过:万一同步到一半断网了,数据少了或者多了怎么办?

这是实时同步最大的坑——分布式环境下,网络断、系统崩都是常事,怎么保证数据不丢、不重,是关键。

应对措施就三个:

- 搞“事务性处理”:要么全同步成功,要么全失败,别出现“半吊子”数据;

- 定期校验:比如每天凌晨,对比源系统和目标系统的数据量、哈希值,不一样就查原因;

- 能回滚:出问题了,能回到上一个正常状态,不用从头同步。

像是FineDataLink就能将数据集成到一个平台、且自动进行清洗转换,不用担心数据杂乱。

2.系统性能与稳定性问题

数据量大的时候,同步工具要是扛不住,不仅同步速度慢,还会影响业务系统。

应对措施得从源头优化:

- 优化数据结构:给数据库加索引、分表,查数据更快;

- 用缓存:常用的数据存在缓存里,不用每次都查数据库;

- 动态分配资源:哪个任务忙,就多给点CPU、内存,别让资源浪费。

3.网络延迟与带宽限制

跨地域同步最头疼这个事了,地域不同,数据传过去得花更长时间,要是碰上带宽限制大,实时性就更差了。

解决办法也简单:

- 压缩数据:把数据压小了再传,比如文本数据压缩后能小一半;

- 选高效协议:不用普通的HTTP,用更省带宽的协议;

- 就近部署:在分公司附近建个节点,数据先存在节点里,再同步到总部,减少距离。

4.安全与隐私保护

数据在网上传输的时候,怕被拦截和改动;存的时候又怕被乱看导致隐私泄露,尤其敏感数据,出问题就麻烦了。

必须做好三件事:

- 传输加密:用SSL/TLS,数据像裹了层安全外套,别人截到也解不开;

- 控制权限:谁能看什么数据,定死了,比如实习生只能看公开数据,不能看敏感信息;

- 记日志:谁查了数据、改了数据,都记下来,出问题能追溯。

Q&A常见问答

Q1:实时数据同步的基本原理是什么?

A:这其实不难理解,核心就两点:抓得准,传得快。

首先,我们需要靠CDC技术盯着数据库日志,数据一有变动,就能够知道并且抓出来;再用消息队列把这些变动当“消息”传出去;要是需要进行二次加工,就可以用流处理在传输的同时把数据洗干净、算好指标。整个过程要保证数据不丢、不重,还得快,这样目标系统才能实时拿到能用的数据。

Q2:如何选择合适的数据同步技术?

A:别看别人用啥就用啥,得看自己的需求:

- 要是同步MySQL、Oracle这种关系型数据库,CDC技术首选,不影响源系统还实时;

- 要是数据量大、吞吐高,Kafka这种消息队列更合适;

- 要是只能通过API拿数据,API轮询也能凑活,但实时性会差一点。

记住,世上没有最好的技术,只有最适合你业务的技术。

👇点击阅读原文,一键get文中同款数据同步工具