英伟达联手康奈尔大学推出GANcraft:将“我的世界”变现实景

创新神经渲染技术实现前所未有的真实感

一张逼真的海岛景观图,并非出自专业摄影师之手,而是由英伟达与康奈尔大学联合研发的GANcraft生成。该技术能将《我的世界》(Minecraft)中低分辨率的马赛克场景,转化为高度逼真的3D渲染图像[1]。

原始输入仅为《我的世界》中的方块化地形,画质粗糙且缺乏细节[1]:

通过GANcraft处理后,实现从像素风到照片级视觉效果的跨越,真正实现“我的世界”到“我的现实”[1]。

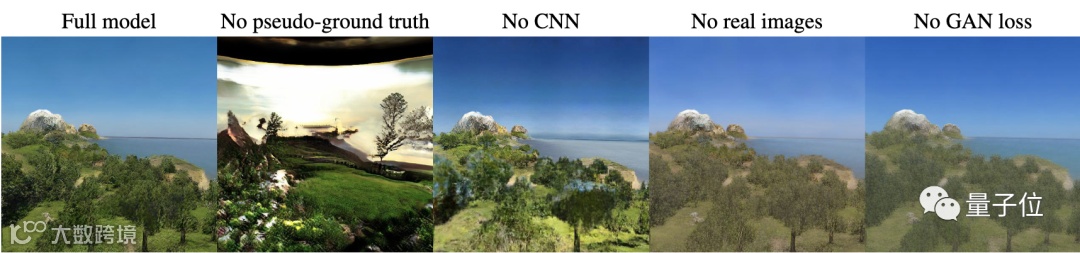

多模型对比凸显性能优势

研究人员将GANcraft与MUNIT、SPADE、wc-vid2vid和NSVF-W等主流图像生成模型进行对比[1]。

结果显示:MUNIT和SPADE作为图像到图像转换方法,无法保持视角一致性,因缺乏3D几何理解且逐帧独立生成[1];wc-vid2vid虽具视图一致性,但受块状结构和域偏移影响,图像质量随时间下降;NSVF-W输出稳定但色彩暗淡、细节缺失[1]。

相比之下,GANcraft不仅保持了动态视角下的空间一致性,还输出高质量、细节丰富的逼真画面[1]:

核心技术:混合体素条件神经渲染

GANcraft采用“混合体素条件神经渲染”方法,融合3D体积渲染器与2D图像空间渲染器[1]。

系统为每个区块角点分配可学习特征向量,结合三线性插值构建连续体积函数,并依据语义标签(如泥土、水、草地)定义场景内容[1]。随后通过MLP隐式建模辐射场,输入位置编码、语义标签与风格码,输出点特征与密度值。

最终,结合相机参数渲染出2D特征图,并由CNN转换为最终图像[1]。

对抗训练引入伪真值提升稳定性

由于《我的世界》场景标签分布特殊(如大面积积雪或水域),直接使用真实照片训练易导致失真[1]:

为此,研究团队采用预训练SPADE模型生成伪真值(Pseudo-ground truth),基于2D语义分割映射生成匹配语义的参考图像[1]。

该策略有效缓解标签-图像错配问题,支持更强损失函数,显著提升训练速度与稳定性,生成效果大幅优化[1]:

支持语义与风格可控,降低3D创作门槛

GANcraft允许用户控制场景语义与输出风格,实现个性化渲染[1]:

项目官网称,该技术让每位《我的世界》玩家都可成为3D艺术家,极大简化复杂场景建模流程,无需专业建模经验即可创作高质量视觉内容[1]。

目前,GANcraft即将开源,相关论文已发布于arXiv平台[2]。