欢迎关注R语言数据分析指南

❝本节来介绍如何在本地部署AI模型,从而可以在离线运行。本地运行好处在于隐私性强,不需要订阅付费,若需求一般可以完全满足。同时本地部署的模型进而还可以进行模型微调,这个才是关键点。本次主要介绍如何安装Ollama,同时通过docker来部署openweb UI来通过交互式界面展示。该方法对电脑配置有一定要求,建议至少内存16G,至于模型可以根据自己的电脑配置来下载。此次测试在Mac mini上进行M4pro-48G内存

最终结果展示

❝目前小编只下载了两个模型,运行deepseek-r1:14b速度可以接受反应不算慢,运行时消耗内存基本在30G左右。

1.安装Ollama

访问https://ollama.com/ 网站下载对应自己系统的版本安装即可

2.安装docker

访问https://www.docker.com/get-started/ 网站下载对应自己系统的版本安装即可 安装完之后运行Ollama与docker

安装完之后运行Ollama与docker

3.部署openweb UI

根据https://github.com/open-webui/open-webui官网介绍选择自己所需的安装方式。下方所示代码在终端运行

docker run -d -p 3000:8080

--add-host=host.docker.internal:host-gateway

-v open-webui:/app/backend/data

--name open-webui

--restart always ghcr.io/open-webui/open-webui:main

运行完之后则会在docker内显示下方信息,点击3000:8080即可在浏览器中打开webUI的界面。首次运行需要创建管理员账号,完成这一步后前期的准备工作已经完成,后续只需要下载模型即可。

4.下载模型

点管理员设设置->模型后可以看到右上角有下载标示

点开后可以看到一行小字点这里。打开后就可以看到一系列模型列表。

点开后可以看到一行小字点这里。打开后就可以看到一系列模型列表。

以第一个为例若要下载deepseek-r1:7b这个模型,则按如下操作输入模型名称后点击右侧下载标示即可,前期的下载速度非常快,但是到98%左右下载则较慢需要耐心等待。完成上述一系列操作后即可愉快的开启本地聊天。

以第一个为例若要下载deepseek-r1:7b这个模型,则按如下操作输入模型名称后点击右侧下载标示即可,前期的下载速度非常快,但是到98%左右下载则较慢需要耐心等待。完成上述一系列操作后即可愉快的开启本地聊天。

关注下方公众号下回更新不迷路

购买介绍

❝本节介绍到此结束,有需要学习R数据可视化的朋友欢迎到淘宝店铺:R语言数据分析指南,购买小编的R语言可视化文档,2025年购买将获取2025年更新的内容,同时将赠送2024年的绘图文档内容。

更新的绘图内容包含数据+代码+注释文档+文档清单,小编只分享案例文档,不额外回答问题,无答疑服务,更新截止2025年12月31日结束,零基础不推荐买。

案例特点

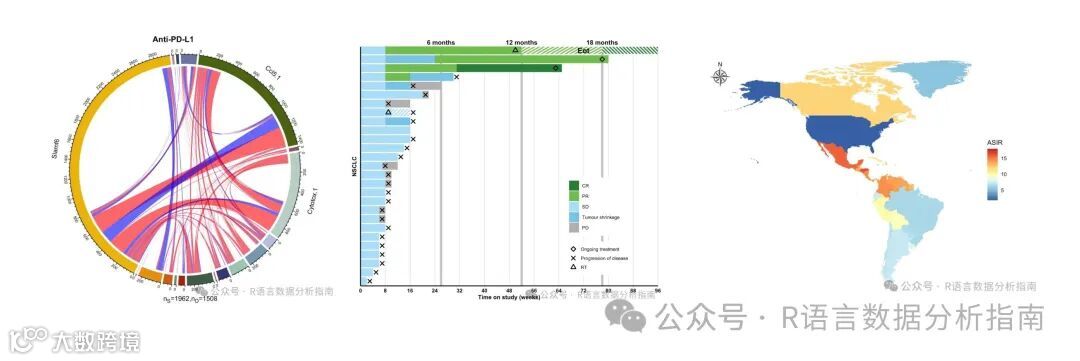

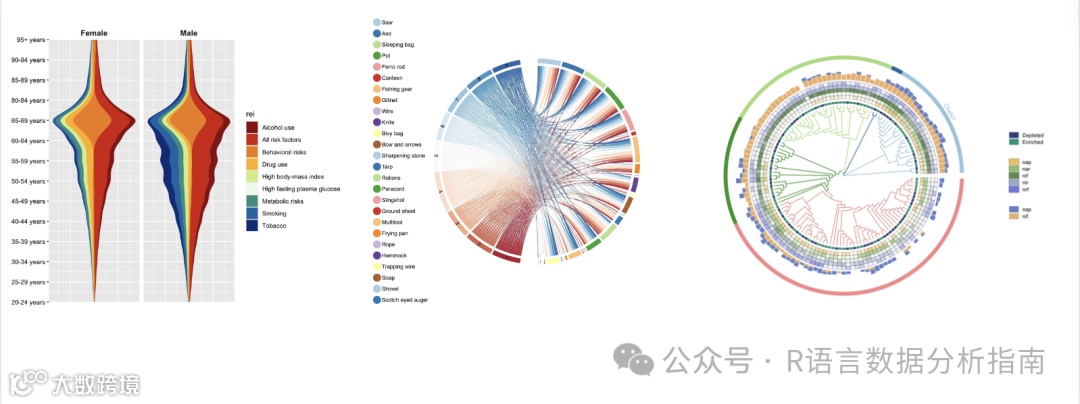

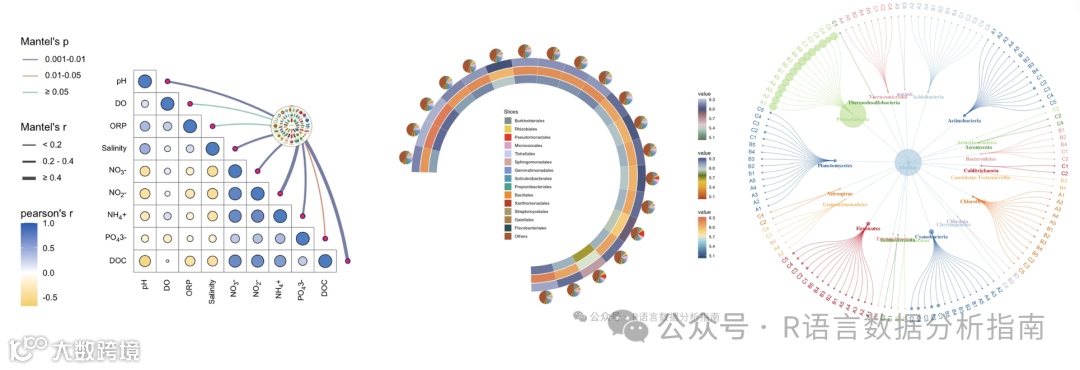

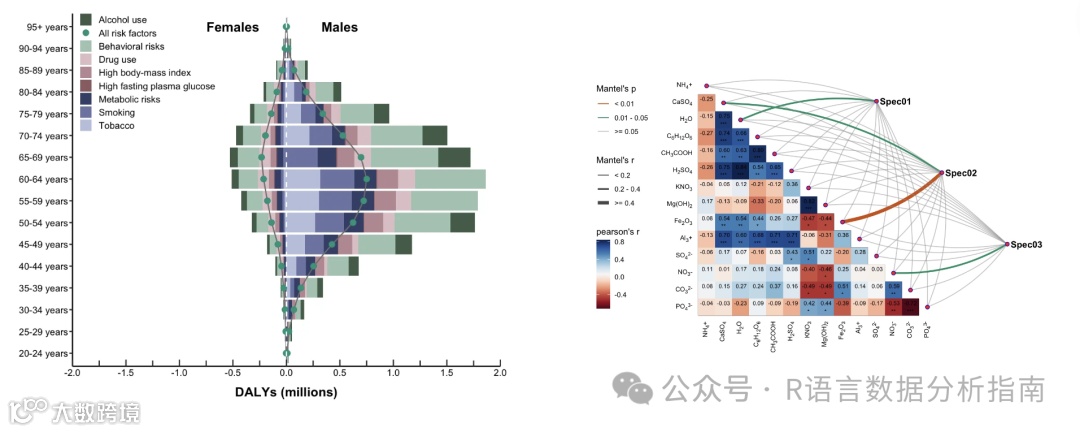

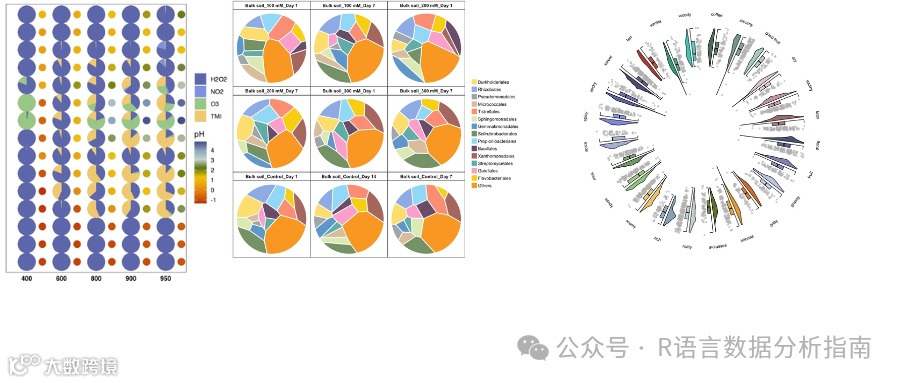

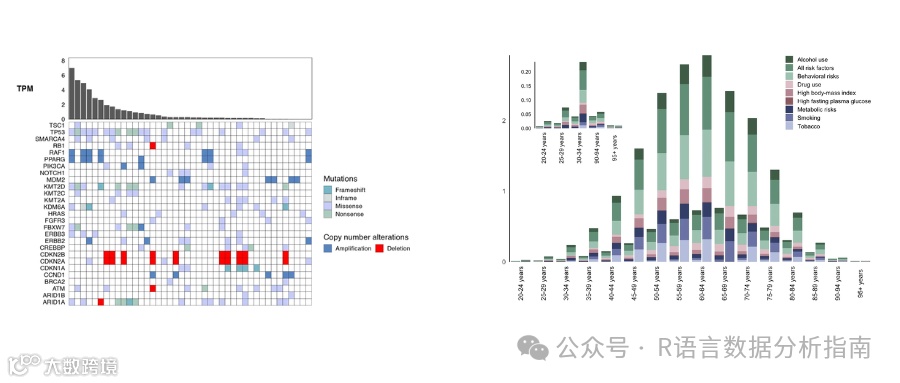

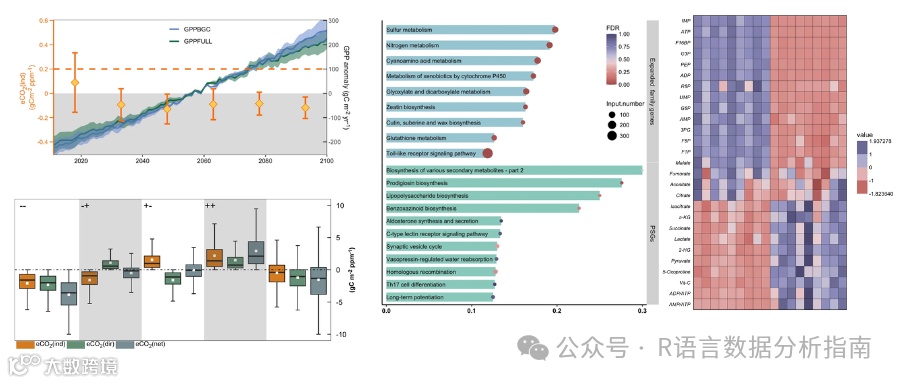

所选案例图均属于个性化分析图表完全适用于论文发表,2025年起提供更加专业的html版注释文档更加直观易学。文档累计上千人次购买拥有良好的社群交流体验。R代码结构清晰易懂,为防止中文乱码提供单独的注释文档

R代码结构清晰易懂,2025年起提供更加专业的htnl文档

R代码结构清晰易懂,2025年起提供更加专业的htnl文档

群友精彩评论

淘宝店铺

2025更新案例图

2024年已更新案例图展示